Der Klimakonsens – eine Religion?

Die aktuelle öffentliche Diskussion und in der Folge die Umweltpolitik scheint nur eine einzige Zielrichtung zu kennen, die Vermeidung des „klimaschädlichen Treibhausgases“ CO2.

Der sogenannte „Klima-Konsens“ beruht auf einer Mischung aus begründeten Fakten, unbegründeten oder falschen Behauptungen, verdrängten und verleugneten Fakten, Vermutungen und vor allem aus Befürchtungen, Spekulationen und Erwartungen über die Zukunft:

- Das Klima wäre bis zum Beginn der Industrialisierung stabil und „gut“ gewesen.

- Die Gleichgewichtstemperatur zwischen Sonneneinstrahlung und Infrarotabstrahlung beträgt 255° K oder -18° C. Dies wäre die Temperatur der Erdoberfläche, wenn es keine Treibhausgase gäbe. Die Treibhausgase bewirkten aktuell eine um 33 Grad höhere Gleichgewichtstemperatur.

- Durch den Anstieg des CO2 Gehalts in der Atmosphäre seit 1850 habe sich die Weltdurchschnittstemperatur bisher um 1 Grad erhöht und wird sich bis zum Ende des Jahrhunderts um weitere 1-5 Grad erhöhen, je nach geschätzter oder angenommener „Klimasensitivität“.

- Das CO2 sei der primäre Faktor der weiteren Temperaturentwicklung und damit die Wurzel allen künftigen Übels auf der Welt.

- Die Rückkopplungs-Faktoren wie Wasserdampf und Wolken würden die Wirkung des CO2 verstärken.

- Die Temperaturerhöhung wirke zerstörerisch durch zunehmende Überflutungen, Waldbrände, Tropenstürme.

- Der Mensch sei verantwortlich für die Erhöhung des

und damit für die Erhöhung der Temperatur

und damit für die Erhöhung der Temperatur - Die angebliche – als Mischung aus Angstmacherei und optimistischer Zukunftsvision getarnte – „Katastrophenformel“ heißt:

- P: Anzahl der Menschen

- S: Indikator für Wohlstand (Services pro Person), also wohnen, heizen, kochen, fahren

- E: Spezifischer Energieverbrauch (Energie pro Service), also die Frage, wieviel Strom der Kühlschrank braucht

- C: Kohlenstoffverbrauch für die Energiegewinnung, also das

pro Energieeinheit

pro Energieeinheit

Das Grundglaubensbekenntnis ist, dass die Frage des ![]() zur „Schuldfrage“ gemacht wird und das Heil der Menschheit in der Vermeidung von

zur „Schuldfrage“ gemacht wird und das Heil der Menschheit in der Vermeidung von ![]() gesucht wird.

gesucht wird.

Die Konsequenz, die die aktuelle Politik daraus zieht: das Heil der Welt beginnt mit dem großen Reset – ![]() Erzeugung auf 0 bringen!

Erzeugung auf 0 bringen!

Mit dieser Formel wird aus einer akademischen Diskussion eine Religion:

- P: Der Mensch sei der Schädling des Planeten => möglichst wenige Menschen, Reduzierung durch Verhütung, Abtreibung und Euthanasie

- S: Statt wie bisher Wohlstand für alle soll Wohlstand wieder zum Luxusgut werden: Flugreisen, schöne Häuser etc. nur noch für wenige Privilegierte.

- E: Thema Energieeffizienz ist im Prinzip sinnvoll, ist bei uns bereits weitgehend ausgereizt, wird aber von Werbung und Politik als Druckmittel verwendet, immer wieder neue Geräte anzuschaffen.

- C: Ziel des „Green Deals“ – Energiegewinnung ohne CO2 bis 2050, merkwürdigerweise in Deutschland ohne Kernkraft.

Die verdrängte Wirklichkeit

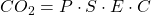

Die dramatisch positiven Auswirkungen des weltweit gestiegenen Energieverbrauchs und der damit verbundenen ![]() -Zunahme werden von den Klimawandel-Gläubigen gezielt verdrängt.

-Zunahme werden von den Klimawandel-Gläubigen gezielt verdrängt.

- Die Lebenserwartung in den armen Ländern hat seit 1950 von 42 Jahre auf heute 72 Jahre zugenommen

- Das Millenium Entwicklungsziel der UN- die Anzahl der „Ärmsten der Armen“ von 1990 bis 2015 zu halbieren, ist bereits vorzeitig 2010 erreicht worden.

- Durch die Zunahme des

Gehalts in der Atmosphäre ist die Erde in den letzten 25 Jahren sehr viel grüner geworden und es werden Rekordernten eingefahren

Gehalts in der Atmosphäre ist die Erde in den letzten 25 Jahren sehr viel grüner geworden und es werden Rekordernten eingefahren

Trotz dieser offensichtlichen Fortschritte für das Wohl der Menschheit, besonders der Armen, bekommen z.B. Afrikanische Staaten bei der Weltbank keine Kredite für Kohlekraftwerke mehr, was deren Entwicklung aktuell massiv behindert. Nur mächtige Staaten mit Entwicklungsbedarf wie China und Indien können sich über solche Nötigungen hinwegsetzen und Kohlekraftwerke nach Belieben selbst bauen.

Im folgenden möchte ich zunächst die wissenschaftlichen Aspekte des Klimas und die Argumente der Vertreter der Klimareligion untersuchen, und zum Schluss deren philosophische Motivation hinterfragen.

Wie geht Klima? Basisfakten der Klima-Physik

Zunächst möchte ich einige elementare unstrittige Zusammenhänge aus der Physik beschreiben, um das umstrittene Thema Treibhauseffekt zu erhellen.

Die Energiebilanz der Erde

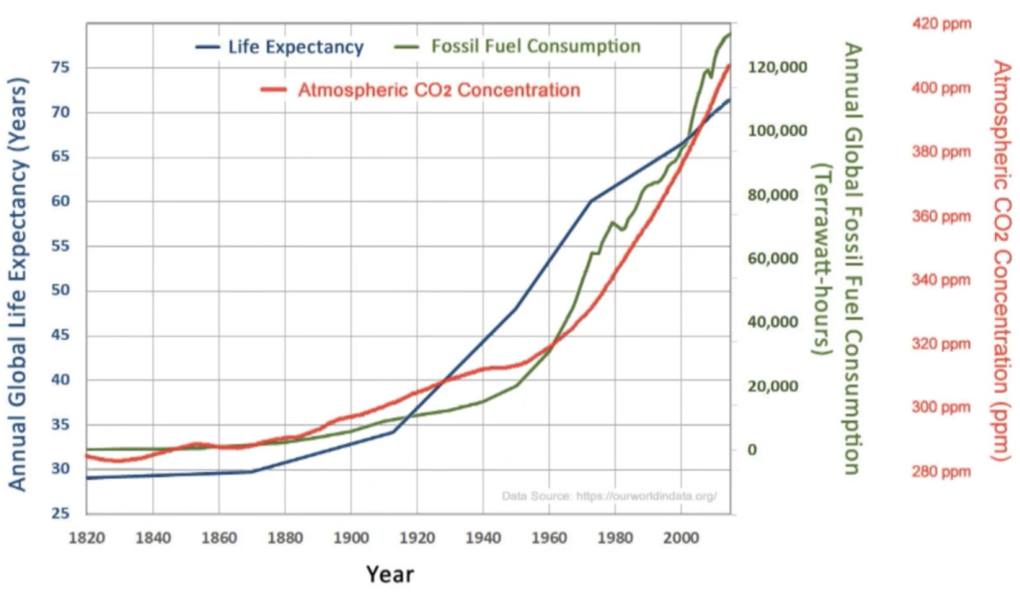

Der Beginn aller Betrachtungen zum globalen Klima ist, dass das Klima auf der Erde nur dann langfristig stabil ist wenn die von der Sonne eingestrahlte Energie (linke Seite der Gleichung) gleich ist mit der von der Erde abgestrahlten Energie (rechte Seite der Gleichung).

![]()

- Die konstante Sonneneinstrahlung S mit 1370 W pro m².

- Der Anteil der von Atmosphäre, Wolken und Erdoberfläche reflektierten Sonneneinstrahlung

.

. - Die abgestrahlte Infrarotstrahlung, die von der Temperatur T abhängt.

- Der Faktor 4 stammt daher, dass die Einstrahlung auf einer Kreisfläche mit dem Erdradius erfolgt und daher zu jedem Zeitpunkt nur der 4. Teil der Erdoberfläche beschienen wird, im Schnitt bekommt daher jeder m² 342 W.

- Der Faktor

ist die sog. Stefan-Boltzmann Konstante.

ist die sog. Stefan-Boltzmann Konstante.

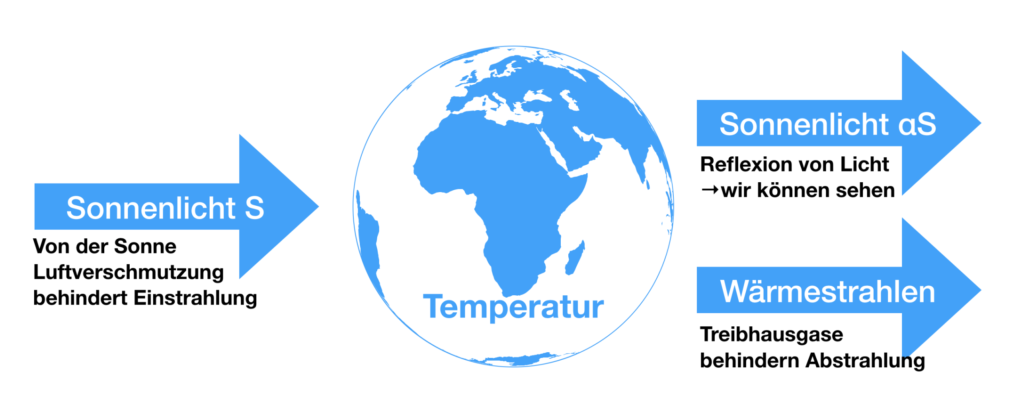

Eine verfeinerte Betrachtung zeigt wie sich das aufteilt:

- insgesamt 30% des eingestrahlten Sonnenlichtes werden durch die Atmosphäre, die Wolken und die Erdoberfläche gleich wieder in den Weltraum zurück reflektiert, hauptsächlich durch die Wolken.

Die restlichen 70%, also durchschnittlich etwa 240 werden durch Ozeane, Land und Luft absorbiert und teilweise gespeichert.

werden durch Ozeane, Land und Luft absorbiert und teilweise gespeichert. - Diese Wärme wird auf 4 verschiedenen Wegen wieder in den Weltraum abgegeben

- 7% durch aufsteigende Luft (Konvektion),

- 23% durch aufsteigender Wasserdampf,

- 21% durch Wärmestrahlung,

- 19% durch in Luft und Wolken absorbiertes Licht

insgesamt wieder 70% der Gesamtenergiemenge.

Bei der Wärmestrahlung gehen 6% direkt von der Erdoberfläche in den Weltraum, das spüren Sie z.B. in einer klaren Nacht, es wird kälter als wenn Wolken da sind.

Um die rot gekennzeichneten 15% „von der Atmosphäre absorbierte Wärmestrahlung“ dreht sich ein großer Teil der Diskussion von Klimaaktivisten – unberechtigterweise. In dieser – korrekten – Darstellung ist das nur ein kleiner Anteil des Energiebudgets, davon wird das meiste durch den Wasserdampf und ein Bruchteil durch das ![]() absorbiert. Aber man kann das so darstellen, dass der falsche Eindruck vermittelt wird, dass durch das

absorbiert. Aber man kann das so darstellen, dass der falsche Eindruck vermittelt wird, dass durch das ![]() eine gigantisch große Gegenstrahlung – größer als die gesamte Sonneneinstrahlung – von der Atmosphäre auf die Erde zurückstrahlt. Eine solche Gegenstrahlung gibt es aber nicht als realen Wärmefluss, sondern nur als mathematische Hilfskonstruktion: Man kann die genannten 15% als Differenz 110%-95% darstellen, und diese 95% dann Gegenstrahlung nennen, um den falschen Eindruck zu erwecken, als würden Strahlungseffekte das Geschehen in der Atmosphäre dominieren. Die Prozentzahlen der Energiebilanz sprechen eine klare andere Sprache, Verdampfung bzw. Kondensation und Luftströmungen dominieren den Wärmetransport in der klimabestimmenden Troposphäre. Zudem fließt Wärmeenergie immer von der wärmeren Erdoberfläche in die kälteren höheren Luftschichten. Es genügt festzuhalten, dass bis auf die 6% Wärmestrahlung, die ungehindert durch die Atmosphäre in den Weltraum gelangen, alle andere Energie letztlich dazu verwendet wird, die Atmosphäre zu erwärmen. Die nächste Frage ist, wie sich diese Wärme dann in der Atmosphäre verteilt und letztlich wieder in den Weltraum abgegeben wird.

eine gigantisch große Gegenstrahlung – größer als die gesamte Sonneneinstrahlung – von der Atmosphäre auf die Erde zurückstrahlt. Eine solche Gegenstrahlung gibt es aber nicht als realen Wärmefluss, sondern nur als mathematische Hilfskonstruktion: Man kann die genannten 15% als Differenz 110%-95% darstellen, und diese 95% dann Gegenstrahlung nennen, um den falschen Eindruck zu erwecken, als würden Strahlungseffekte das Geschehen in der Atmosphäre dominieren. Die Prozentzahlen der Energiebilanz sprechen eine klare andere Sprache, Verdampfung bzw. Kondensation und Luftströmungen dominieren den Wärmetransport in der klimabestimmenden Troposphäre. Zudem fließt Wärmeenergie immer von der wärmeren Erdoberfläche in die kälteren höheren Luftschichten. Es genügt festzuhalten, dass bis auf die 6% Wärmestrahlung, die ungehindert durch die Atmosphäre in den Weltraum gelangen, alle andere Energie letztlich dazu verwendet wird, die Atmosphäre zu erwärmen. Die nächste Frage ist, wie sich diese Wärme dann in der Atmosphäre verteilt und letztlich wieder in den Weltraum abgegeben wird.

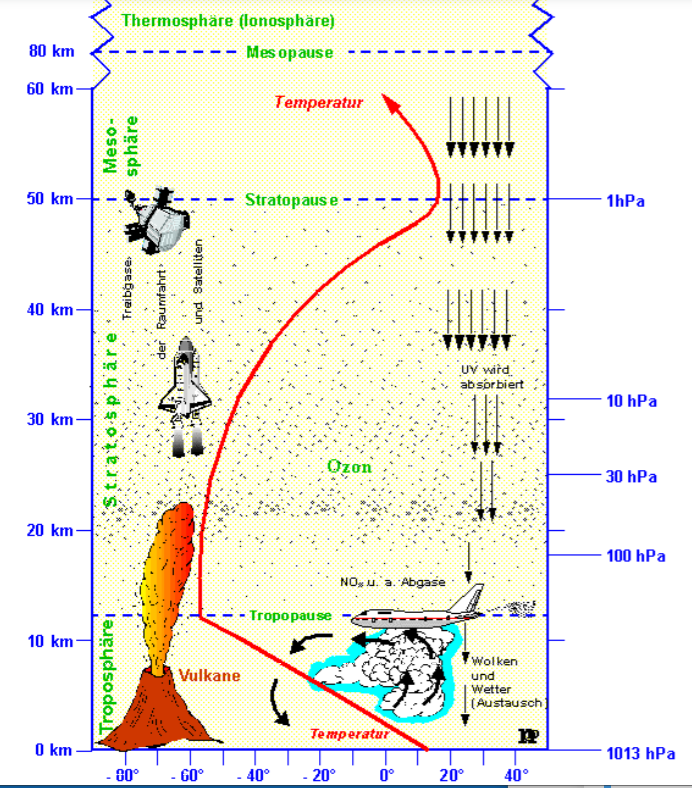

Der Temperaturgradient der Atmosphäre

Jeder Bergwanderer kennt die „Bergsteiger“-Regel, dass beim Anstieg mit je 100m Höhenunterschied im Schnitt die Temperatur um etwa 1° C abnimmt, bei feuchtem Wetter ist es weniger. Symbol dafür sind die mitten in den Tropen stehenden Berge wie der Kilimandscharo:

Die Voraussetzung für diesen Temperaturgradienten ist das lokale thermodynamische Gleichgewicht, d.h. die Luftmoleküle stoßen so häufig aufeinander, dass alle Energie-Unterschiede schnell ausgeglichen werden. Das gilt überall dort, wo man mit einem normalen Thermometer die Temperatur messen kann, also bis zum oberen Rand er Troposphäre, in etwa 12-14km Höhe. Außerdem wird zur Erklärung des Phänomens angenommen, dass keine Energie von außen zugeführt wird oder abfließt, wir sprechen von einem adiabatischen Zustand.

Anschaulich muss man sich vorstellen, was mit einem einzelnen Molekül passiert, wenn es sich z.B. nach oben bewegt: Aufgrund der Schwerkraft verliert es einen Teil seiner Bewegungsenergie, wird also kälter. Umgekehrt wird es bei einer Bewegung nach unten durch die Schwerkraft schneller, also wärmer. Der Gleichgewichtszustand ist also nicht dann erreicht, wenn alle Moleküle gleich warm sind, wie wir es üblicherweise kennen, sondern wenn die etwas höher gelegenen Moleküle ein wenig kälter sind. Die Rate der Änderung, der Temperaturgradient, hängt nur von der Gravitationskonstante und der Wärmekapazität der Luft ab. Deswegen ist der Temperaturgradient in feuchter Luft kleiner, weil diese eine höhere Wärmekapazität hat. Der über die ganze Atmosphäre gemittelte Temperaturgradient ![]() beträgt -6.5 °C pro km Höhenunterschied.

beträgt -6.5 °C pro km Höhenunterschied.

Aus der Graphik wird erkennbar, dass innerhalb der Troposphäre die Temperatur streng linear abfällt, also ausschließlich die beschriebene thermodynamische Ursache hat, was nichts mit Treibhausgasen oder Strahlungseffekten zu tun hat. Die Abweichung von dieser strengen Linie oberhalb der Tropopause bedeutet, die Luft ist dort so dünn und die Stöße der Luftmoleküle werden seltener, und die Strahlungseffekte überwiegen.

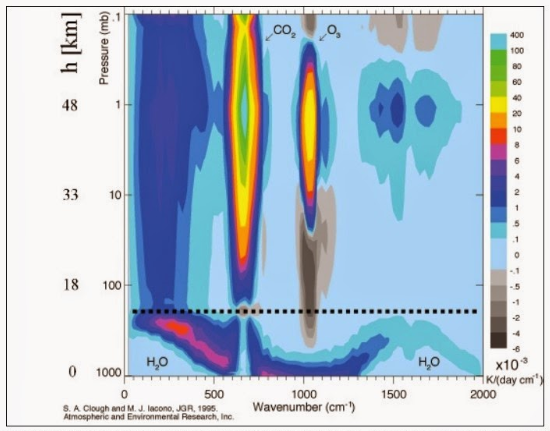

Der Energiefluß in den Weltraum

Um Wärme-Energie wirklich „loszuwerden“, gibt es für die Erde nur eine Möglichkeit – es muss in Form von Strahlungsenergie geschehen. Diese Strahlung ist im Infrarotbereich, also Wärmestrahlung. Seit es entsprechende Satelliten gibt, lässt sich diese Strahlung messen, sogar in Abhängigkeit von der Wellenlänge der Strahlung, das wird Emissions-Spektrum genannt. Dies ist der komplizierteste Teil der heutigen Präsentation, und hier findet auch das statt, was man Treibhauseffekt nennt, diese Überlegungen sind sehr wichtig, um sich ein Bild über die Größenordnung des Effekts zu machen.

Ein „ideales“ Spektrum ohne Treibhausgase würde als „idealer Planck’scher Strahler“ einer der gestrichelten Temperaturkurven folgen, im betrachteten Fall der Kurve T=320° K, was 47° C entspricht. Das wäre die Temperatur der Erdoberfläche – das Spektrum ist über der Sahara-Wüste aufgenommen.

In dem Diagramm sind zwei Kurven:

- Die schwarze sind die vom Satelliten gemessenen Werte

- Die rotbraune stammen von einem Simulationsprogramm namens MODTRAN. Der Umstand, dass die beiden Kurven so hervorragend übereinstimmen, zeigt, das der Strahlungstransport in der Atmosphäre von der Physik gut verstanden ist, und es ermöglicht, mit dem durch MODTRAN gegebenen vereinfachten Atmosphärenmodell wichtige Klimafragen zu beantworten. Darauf werde ich noch zurückkommen.

Von welcher Höhe aus die Infrarotstrahlung in den Weltraum abgestrahlt wird, hängt stark von deren Wellenlänge bzw. Wellenzahl ab. Die Treibhausgase in der Atmosphäre, vor allem Wasserdampf und ![]() absorbieren Infrarotstrahlung in den für sie spezifischen Wellenzahlbereichen. Erst wenn die Luft so dünn ist, dass in dem betreffenden Wellenzahlbereich zu wenige Atome sind, um die Strahlung wieder zu absorbieren, kann die Infrarotstrahlung die Atmosphäre verlassen. Der Fachbegriff heißt „optische Dichte“ – Abstrahlung in den Weltraum findet statt, wenn die optische Dichte zum Weltraum hin kleiner als 1 wird, vereinfacht gesagt, sobald die Atmosphäre für die betreffende Wellenzahl durchsichtig wird.

absorbieren Infrarotstrahlung in den für sie spezifischen Wellenzahlbereichen. Erst wenn die Luft so dünn ist, dass in dem betreffenden Wellenzahlbereich zu wenige Atome sind, um die Strahlung wieder zu absorbieren, kann die Infrarotstrahlung die Atmosphäre verlassen. Der Fachbegriff heißt „optische Dichte“ – Abstrahlung in den Weltraum findet statt, wenn die optische Dichte zum Weltraum hin kleiner als 1 wird, vereinfacht gesagt, sobald die Atmosphäre für die betreffende Wellenzahl durchsichtig wird.

Aus diesem Emissionsspektrum können wir im wesentlichen 3 Wege der abfließenden Wärmeenergie erkennen:

- Bei Wellenzahlen von

ist das „atmosphärische Fenster“, in dem die wolkenlose Atmosphäre für die Infrarotstrahlung nahezu transparent ist, und die Strahlungstemperatur entspricht der Temperatur der Erdoberfläche von 310-320° K. Diese Wärme strahlt direkt von der Erdoberfläche aus in den Weltraum. Der Umstand, dass in diesem Bereich in der Stratosphäre auch ein „Ozon“-Band ist, hat fast keine Auswirkungen, weil sich in Bodennähe kaum Ozon befindet.

ist das „atmosphärische Fenster“, in dem die wolkenlose Atmosphäre für die Infrarotstrahlung nahezu transparent ist, und die Strahlungstemperatur entspricht der Temperatur der Erdoberfläche von 310-320° K. Diese Wärme strahlt direkt von der Erdoberfläche aus in den Weltraum. Der Umstand, dass in diesem Bereich in der Stratosphäre auch ein „Ozon“-Band ist, hat fast keine Auswirkungen, weil sich in Bodennähe kaum Ozon befindet. - Zwischen der Wellenzahl

liegt das

liegt das  -Band.

-Band.  ist homogen in der Atmosphäre verteilt, wobei das Strahlungsmaximum in der Stratosphäre einer eher niedrigen Strahlungstemperatur von etwa 220° K (-53° C) entspricht. Eine Temperatur, die interessanterweise weder von der

ist homogen in der Atmosphäre verteilt, wobei das Strahlungsmaximum in der Stratosphäre einer eher niedrigen Strahlungstemperatur von etwa 220° K (-53° C) entspricht. Eine Temperatur, die interessanterweise weder von der  -Konzentration noch von der Temperatur der Erdoberfläche abhängt. Man spricht davon, dass das

-Konzentration noch von der Temperatur der Erdoberfläche abhängt. Man spricht davon, dass das  Band weitgehend „gesättigt“ ist und sich bei weiterer Erhöhung der

Band weitgehend „gesättigt“ ist und sich bei weiterer Erhöhung der  -Konzentration kaum mehr verändert. Diese „Wärme“ (-53° C) verlässt die Atmosphäre überwiegend von der Stratosphäre aus, von 18-60 km Höhe. Das heißt, das

-Konzentration kaum mehr verändert. Diese „Wärme“ (-53° C) verlässt die Atmosphäre überwiegend von der Stratosphäre aus, von 18-60 km Höhe. Das heißt, das  blockiert den Abfluss von Wärme in „seinem“ Wellenzahlbereich. Aber: Dieser Bereich ändert sich kaum, wenn der Atmosphäre zusätzliches

blockiert den Abfluss von Wärme in „seinem“ Wellenzahlbereich. Aber: Dieser Bereich ändert sich kaum, wenn der Atmosphäre zusätzliches  zugeführt wird.

zugeführt wird.

- Mit dem

-Band überlappt das Wasserdampfband mit der Wellenzahl

-Band überlappt das Wasserdampfband mit der Wellenzahl  . Zwischen

. Zwischen  und

und  befindet sich ein weiteres Wasserdampfband. Wasser und Wasserdampf dominieren mit großem Abstand das gesamte Klimageschehen, und insbesondere auch die Abstrahlung von Wärme in den Weltraum. Aus der folgenden Abbildung geht hervor, dass die Wasserdampfkonzentration in 5 km Höhe stark abnimmt. Daher ist die Strahlungstemperatur des Wasserdampfbandes deutlich höher als die von

befindet sich ein weiteres Wasserdampfband. Wasser und Wasserdampf dominieren mit großem Abstand das gesamte Klimageschehen, und insbesondere auch die Abstrahlung von Wärme in den Weltraum. Aus der folgenden Abbildung geht hervor, dass die Wasserdampfkonzentration in 5 km Höhe stark abnimmt. Daher ist die Strahlungstemperatur des Wasserdampfbandes deutlich höher als die von  , ca. 250-280° K, also wird vom Wasserdampf sehr viel mehr Energie abgestrahlt als vom

, ca. 250-280° K, also wird vom Wasserdampf sehr viel mehr Energie abgestrahlt als vom  .

.  ist aber gleichmäßig verteilt und dort wo die Zahl der Wassermoleküle abnimmt, überwiegt die Zahl der

ist aber gleichmäßig verteilt und dort wo die Zahl der Wassermoleküle abnimmt, überwiegt die Zahl der  -Moleküle und die vom Wasserdampf im

-Moleküle und die vom Wasserdampf im  -Band emittierte Infrarotstrahlung wird von höher reichenden

-Band emittierte Infrarotstrahlung wird von höher reichenden  -Molekülen absorbiert und schließlich von

-Molekülen absorbiert und schließlich von  in größerer Höhe und meist niedrigerer Temperatur emittiert. Die stark reduzierte Temperatur des Infrarot abstrahlenden

in größerer Höhe und meist niedrigerer Temperatur emittiert. Die stark reduzierte Temperatur des Infrarot abstrahlenden  , also das „Loch“ im Spektrum ist das eigentliche Treibhaus-Phänomen, das die aktuelle Diskussion so antreibt, weil das

, also das „Loch“ im Spektrum ist das eigentliche Treibhaus-Phänomen, das die aktuelle Diskussion so antreibt, weil das  -Band wie eine selektive Isolierschicht einer Thermoskanne wirkt, aber eben nur für einen kleinen Teil des ganzen Spektrums, und dieser Teil ändert sich kaum, wie wir sehen werden, wenn man zusätzliches

-Band wie eine selektive Isolierschicht einer Thermoskanne wirkt, aber eben nur für einen kleinen Teil des ganzen Spektrums, und dieser Teil ändert sich kaum, wie wir sehen werden, wenn man zusätzliches  zuführt.

zuführt.

Berechnung der Gleichgewichtstemperatur

Nach diesen Vorüberlegungen haben wir die Voraussetzungen, um die Gleichgewichtstemperatur der Erde zu berechnen und sie richtig zu deuten. Wir haben festgestellt, dass die 3 verschiedenen Infrarot-Komponenten aus unterschiedlicher Höhe und daher mit unterschiedlicher Temperatur Wärmeenergie abgeben. Wir wissen wenig über die genaue Verteilung der Wolken, was es schwierig macht, über das Abstrahlverhalten des sog. Atmosphärischen Fensters etwas auszusagen. Angesichts all dieser Probleme nehmen wir der Einfachheit halber an, dass die gesamte Infrarotstrahlung von einer einzigen Abstrahlhöhe aus in das Weltall gelangt. Da wir wissen, dass der überwiegende Teil der Abstrahlung durch den Wasserdampf erfolgt, und die „Dichtegrenze“ des Wasserdampfes in etwa 5 km Höhe ist, erwarten wir, dass die „effektive Abstrahlhöhe“ sich ungefähr in 5 km Höhe befindet.

Eine kleine Bemerkung zu den Maßeinheiten: Für alle Berechnungen müssen wir die absolute Temperaturskala Kelvin verwenden, zur Veranschaulichung wechsle ich dann bisweilen zur gewohnten Celsius-Skala.

Wir nutzen unsere am Anfang aufgestellte Gleichung des Energiegleichgewichts ![]()

Mit ![]() und

und ![]() ergibt sich der mittlere Energiefluß:

ergibt sich der mittlere Energiefluß:![]()

Dies lösen wir nach der effektiven Temperatur ![]() auf:

auf: ![]() °K = 255° K = -18° C

°K = 255° K = -18° C

Das ist sie nun, die berühmte Gleichgewichtstemperatur von -18° C, die in der Klimareligion als die Temperatur der Erdoberfläche angegeben wird, wenn es keine Treibhausgase gäbe, und die Differenz von 33° C zur tatsächlichen Mitteltemperatur von 15 °C wäre durch den Treibhauseffekt verursacht. Diese Aussage ist aber insofern falsch, denn wenn es keine Treibhausgase gäbe, also auch keinen Wasserdampf, dann gäbe es auch keine Wolken, und die durchschnittliche Albedo ![]() , also die Licht-Reflexivität der Erde wäre nicht 0.3, sondern nur 0.125, und die Gleichgewichtstemperatur

, also die Licht-Reflexivität der Erde wäre nicht 0.3, sondern nur 0.125, und die Gleichgewichtstemperatur ![]() der Erde wäre dann:

der Erde wäre dann: ![]() °K

°K ![]() °K = -3 °C

°K = -3 °C

Was bedeutet dann die effektive Gleichgewichtstemperatur ![]() ° K? Es ist die Abstrahltemperatur einer durchschnittlichen effektiven Abstrahlhöhe

° K? Es ist die Abstrahltemperatur einer durchschnittlichen effektiven Abstrahlhöhe ![]() . Um diese effektive Abstrahlhöhe

. Um diese effektive Abstrahlhöhe ![]() zu bestimmen, nutzen wir den besprochenen mittleren Temperaturgradienten

zu bestimmen, nutzen wir den besprochenen mittleren Temperaturgradienten ![]() mit -6.5 °C pro km und die gemessene mittlere Oberflächentemperatur der Erde

mit -6.5 °C pro km und die gemessene mittlere Oberflächentemperatur der Erde ![]() die wir mit 288° K als gegeben annehmen:

die wir mit 288° K als gegeben annehmen:

![]()

Die 33° Differenz zwischen effektiver Abstrahltemperatur und Bodentemperatur wird also nicht in erster Linie durch eine Gegenstrahlung hervorgerufen, sondern durch den Umstand, dass die Atmosphäre mit zunehmender Höhe kälter wird und nur an ihrem Rand Infrarotstrahlung in das Weltall abgeben kann. Wo der Rand genau liegt, hängt von der Wellenzahl bzw. Wellenlänge der Infrarotstrahlung ab, und natürlich von der Zusammensetzung der Atmosphäre. Der Treibhauseffekt ist also abhängig von der Dicke der optisch dichten Atmosphäre, weswegen es auf dem Mars gar keinen und auf der Venus mit ihrer 90 fach schwereren Atmosphäre als die der Erde einen extrem großen Treibhauseffekt gibt.

An dieser Stelle halten wir fest, dass der Wärmeabgabe überwiegend durch die langwellige Infrarotabstrahlung des Wasserdampfes und die Reflexion des kurzwelligen Lichtes an Wolken geschieht, und dass ![]() im Vergleich dazu eine geringfügige Rolle zu spielen scheint. Den genauen

im Vergleich dazu eine geringfügige Rolle zu spielen scheint. Den genauen ![]() -Einfluss wollen wir im nächsten Abschnitt betrachten.

-Einfluss wollen wir im nächsten Abschnitt betrachten.

Die Billionen-€-Frage der CO2-Sensitivität

Die zentrale Frage der ganzen Klimadiskussion dreht sich um ein einziges Thema: Wie ändert sich das Klima, insbesondere die Welt-Durchschnittstemperatur, wenn sich der ![]() -Gehalt der Atmosphäre verdoppelt. Dies nennt man die sogenannte Klima-Sensitivität, die Stellschraube aller Klimapolitik. Ausgehend von den unterschiedlichen Modellvorstellungen des Internationalen Klimarates, des IPCC, droht uns bis Ende des Jahrhunderts eine durchschnittliche Temperaturerhöhung von 2°-5° C. Das politische „Optimalziel“ des Pariser Klimaabkommens ist eine Beschränkung auf 1.5° C.

-Gehalt der Atmosphäre verdoppelt. Dies nennt man die sogenannte Klima-Sensitivität, die Stellschraube aller Klimapolitik. Ausgehend von den unterschiedlichen Modellvorstellungen des Internationalen Klimarates, des IPCC, droht uns bis Ende des Jahrhunderts eine durchschnittliche Temperaturerhöhung von 2°-5° C. Das politische „Optimalziel“ des Pariser Klimaabkommens ist eine Beschränkung auf 1.5° C.

Das Problem ist, dass die sich daraus ergebenden Vorgaben hinsichtlich ![]() -Vermeidung auf einer angenommenen Klimasensitivität von 2°-3° C bei Verdopplung des

-Vermeidung auf einer angenommenen Klimasensitivität von 2°-3° C bei Verdopplung des ![]() -Gehaltes beruhen.

-Gehaltes beruhen.

Ist das korrekt? Ungeheure Kosten, der Industriestandort Deutschland und die dadurch bedingte Verarmung, nicht zuletzt unsere Freiheit hängen von der richtigen Antwort auf diese Frage ab.

Ein einfaches Klimamodell

Wir wollen die beschriebene bewährte MODTRAN-Simulation als eindimensionales Mini-Klimamodell verwenden, um die Frage der Klima-Sensitivität zu beantworten. Diese Vereinfachung ist insofern legitim, weil das Strahlungsgleichgewicht im Prinzip damit an jedem Ort der Erde berechnet werden kann und wenn unter den verschiedenen Bedingungen ein konsistentes Endergebnis herauskommt, dann halten wir es für verlässlich. Das Programm ist öffentlich zugänglich, daher ist alles überprüfbar. Wir wollen uns heute auf eine Beispielrechnung mit der Standardatmosphäre beschränken.

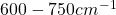

Dazu stellen wir das MODTRAN Programm so ein, wie die Atmosphäre 1850 etwa gewesen war, insbesondere war der ![]() Gehalt damals 280 ppm. Alle anderen Luftbestandteile bleiben auf dem voreingestellten „Standard“-Durchschnittswert. Das Atmosphärenmodell ist die sogenannte US Standard-Atmosphäre, wie sie auch in der Internationalen Luftfahrt erfolgreich verwendet wird. Als Wolkenmodell habe ich diejenigen Wolken gewählt, die am häufigsten vorkommen, die Cumulus-Wolken zwischen 660m und 2700m Höhe. Der Wasserdampfgehalt wird dann so eingestellt, dass die Infrarot-Abstrahlung gerade den korrekten Wert von etwa 240

Gehalt damals 280 ppm. Alle anderen Luftbestandteile bleiben auf dem voreingestellten „Standard“-Durchschnittswert. Das Atmosphärenmodell ist die sogenannte US Standard-Atmosphäre, wie sie auch in der Internationalen Luftfahrt erfolgreich verwendet wird. Als Wolkenmodell habe ich diejenigen Wolken gewählt, die am häufigsten vorkommen, die Cumulus-Wolken zwischen 660m und 2700m Höhe. Der Wasserdampfgehalt wird dann so eingestellt, dass die Infrarot-Abstrahlung gerade den korrekten Wert von etwa 240 ![]() aufweist. Das ist mit einem durchschnittlichen relativen Wasserdampfgehalt von 0.25 gegeben. Die angenommene Durchschnitts-Oberflächentemperatur der Standardatmosphäre ist 15.2° C:

aufweist. Das ist mit einem durchschnittlichen relativen Wasserdampfgehalt von 0.25 gegeben. Die angenommene Durchschnitts-Oberflächentemperatur der Standardatmosphäre ist 15.2° C:

Das dunkelblaue Spektrum zeigt das bereits besprochene Verhalten. Das ![]() -Loch ist sehr ähnlich wie wir es schon kennen, der Einfluss des Wasserdampfes am rechten und am linken Rand ist ebenfalls gut erkennbar. Als Hilfslinien sind zusätzlich die Kurven eingetragen, die das ideale Strahlungsverhalten ohne Treibhausgase bei den Temperaturen 220° K bis 300° K kennzeichnen. Damit kann man die Abstrahltemperatur und damit die Energie an jeder Stelle des Spektrums schätzen.

-Loch ist sehr ähnlich wie wir es schon kennen, der Einfluss des Wasserdampfes am rechten und am linken Rand ist ebenfalls gut erkennbar. Als Hilfslinien sind zusätzlich die Kurven eingetragen, die das ideale Strahlungsverhalten ohne Treibhausgase bei den Temperaturen 220° K bis 300° K kennzeichnen. Damit kann man die Abstrahltemperatur und damit die Energie an jeder Stelle des Spektrums schätzen.

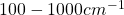

Als nächsten Test wollen wir den heutigen ![]() -Gehalt von 415 ppm einstellen. Die Kurve von 1850 bleibt als blaue Referenz-Kurve im Hintergrund, und die rote Kurve von heute wird „darüber“ gezeichnet.

-Gehalt von 415 ppm einstellen. Die Kurve von 1850 bleibt als blaue Referenz-Kurve im Hintergrund, und die rote Kurve von heute wird „darüber“ gezeichnet.

Was als erstes auffällt, ist, dass die Kurven fast identisch sind, und mit bloßem Auge nicht zu unterscheiden. Die rote Kurve verdeckt die blaue fast vollständig. Nur in den berechneten Werte links sieht man einen leichten Unterschied. Die um etwa 1 ![]() geringere Abstrahlung wird durch eine Temperaturerhöhung der Erdoberfläche von 0.3° kompensiert. Diese durchschnittlich 0.3° sind der effektive Treibhauseffekt seit Beginn der Industrialisierung bis heute, aufgrund des weithin akzeptierten MODTRAN Modells.

geringere Abstrahlung wird durch eine Temperaturerhöhung der Erdoberfläche von 0.3° kompensiert. Diese durchschnittlich 0.3° sind der effektive Treibhauseffekt seit Beginn der Industrialisierung bis heute, aufgrund des weithin akzeptierten MODTRAN Modells.

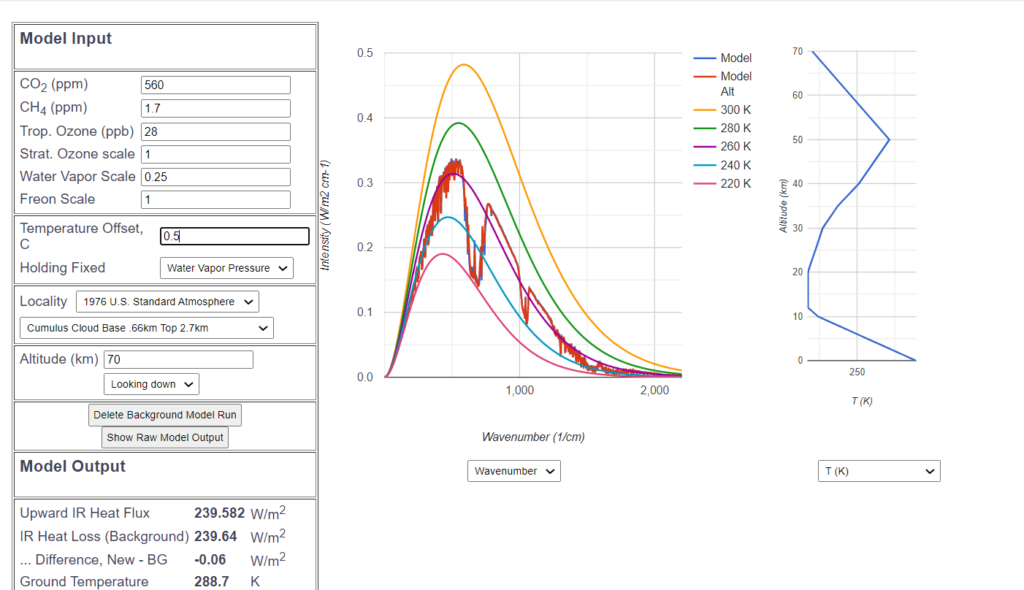

Wie ist es nun, wenn wir eine Verdoppelung des ![]() Gehaltes von 280 ppm auf 560 ppm annehmen? Wiederum wird die neue Kurve der ursprünglichen blauen Kurve überlagert.

Gehaltes von 280 ppm auf 560 ppm annehmen? Wiederum wird die neue Kurve der ursprünglichen blauen Kurve überlagert.

Und wiederum sind mit bloßem Auge kaum Unterschiede zu erkennen – einige kleine blaue Spitzen schauen bei der Wellenzahl 500 heraus, und die „![]() „-Wanne ist einen Hauch breiter geworden. Um die aufgrund dieses minimalen Treibhauseffektes verminderte Infrarot-Abstrahlung zu kompensieren, wird die Bodentemperatur um insgesamt 0.5° C erhöht. Damit beträgt die Klimasensitivität mit der vorgenommenen MODTRAN Simulation ziemlich genau ein halbes Grad.

„-Wanne ist einen Hauch breiter geworden. Um die aufgrund dieses minimalen Treibhauseffektes verminderte Infrarot-Abstrahlung zu kompensieren, wird die Bodentemperatur um insgesamt 0.5° C erhöht. Damit beträgt die Klimasensitivität mit der vorgenommenen MODTRAN Simulation ziemlich genau ein halbes Grad.

Demnach besteht keinerlei Grund zu irgendeinem Alarmismus. Dieser Wert ist weit unterhalb der niedrigsten Annahmen des Weltklimarates.

Warum kommt der Weltklimarat zu anderen Ergebnissen

Die natürliche Frage nach diesen Überlegungen ist, warum der Weltklimarat, in dem ja die besten Klimaforscher vertreten sind, zu so viel pessimistischeren Ergebnissen kommen?

Ein zentrales Problem dabei ist, dass deren Klimamodelle extrem komplex sind und den Anspruch haben, die gesamte Komplexität des Klimageschehens abzubilden. Es gibt gute Gründe anzunehmen, dass dies unter den heutigen Voraussetzungen grundsätzlich nicht möglich ist, z.B. weil turbulente energiereiche Phänomene wie Meeresströmungen oder Tropenstürme in diesen Modellen nicht angemessen abbildbar sind. Ähnliche Modelle werden zur Wettervorhersage verwendet, und diese versagen bekanntlich bereits häufig bei Vorhersagen, die über wenige Tage hinausgehen.

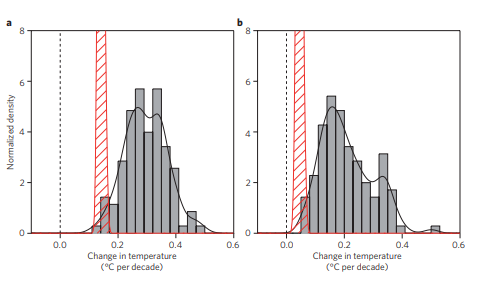

Ein wichtiger Grund, die Gültigkeit der „globalen Zirkulationsmodelle“, kurz GCM genannt, anzuzweifeln, ist der, dass sie in zurückliegenden Vorhersagen für vergangene Klimadaten zu hohe Werte vorhergesagt haben.

Links die durchschnittliche Temperaturentwicklung (roter Balken) 1993-2012 – 0.15°/10 Jahre, rechts dasselbe im Zeitraum 1998-2012 – 0.03°/10 Jahre, und dazu die Ergebnisse von 110 verschiedenen Klimamodellen. Fast alle hatten deutlich höhere Temperaturen geschätzt.

Simulation der IPCC-Annahmen

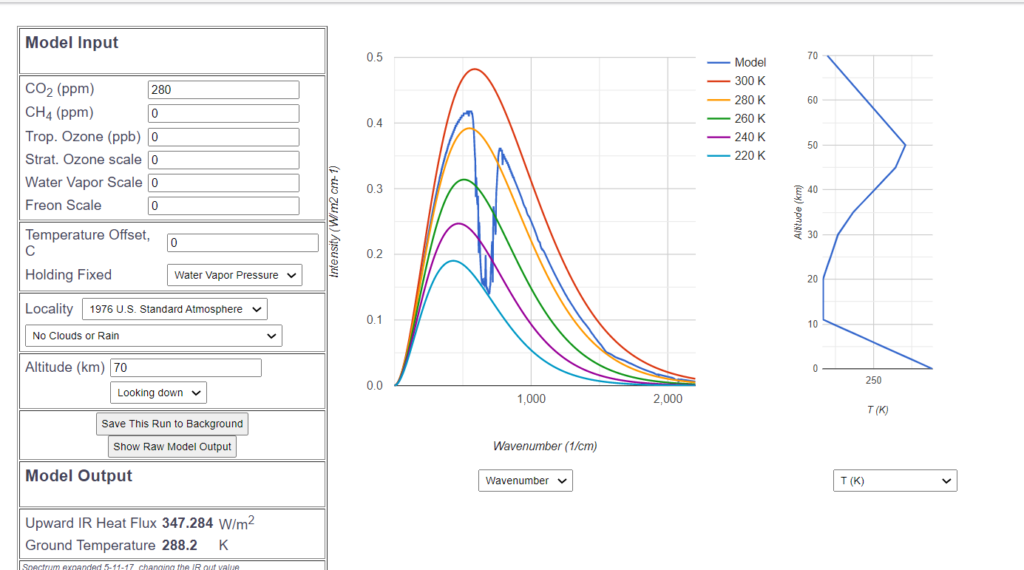

Mit dem MODTRAN Simulationsprogramm kann man aufgrund der von IPCC-nahen Autoren publizierten Daten allerdings deren Denkweise nachvollziehen. Dazu wird zunächst eine Atmosphäre ganz ohne Wasserdampf und ohne die anderen Treibhausgase angenommen, und dort die ![]() Sensitivität gemessen.

Sensitivität gemessen.

Mit der MODTRAN Simulation wird diese Situation erreicht, wenn in der Standard-Atmosphäre alles bis auf den ![]() Gehalt auf 0 gesetzt wird, also auch keine Wolken, kein Wasserdampf.

Gehalt auf 0 gesetzt wird, also auch keine Wolken, kein Wasserdampf.

Damit steigt natürlich die hypothetische Abstrahlung auf einen unrealistisch hohen Wert von 347 ![]() . Deutlich ist als einzige Abweichung von der „Idealkurve“ das bekannte

. Deutlich ist als einzige Abweichung von der „Idealkurve“ das bekannte ![]() -Loch zu erkennen.

-Loch zu erkennen.

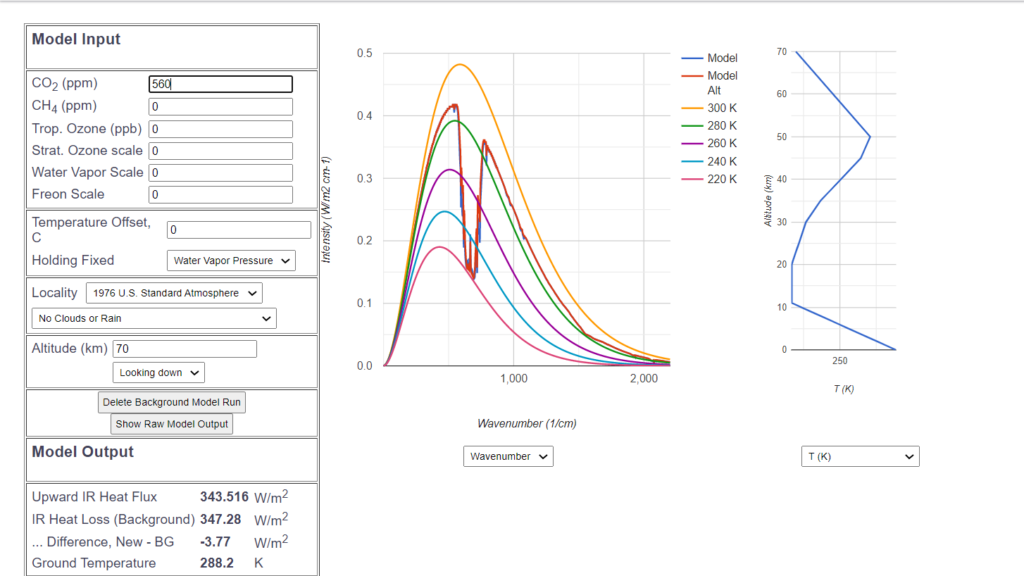

Bei Verdoppelung des ![]() -Gehalts und gleichbleibender Bodentemperatur sinkt aufgrund des Treibhauseffekts jetzt die Abstrahlung um 3.77

-Gehalts und gleichbleibender Bodentemperatur sinkt aufgrund des Treibhauseffekts jetzt die Abstrahlung um 3.77 ![]() .

.

Das ist ziemlich genau der vom Weltklimarat veröffentlichte Wert des ![]() bedingten „Strahlungsantriebs“ („radiative forcings“). Die verminderte Abstrahlung wird durch Temperaturerhöhung kompensiert:

bedingten „Strahlungsantriebs“ („radiative forcings“). Die verminderte Abstrahlung wird durch Temperaturerhöhung kompensiert:

Demnach gleicht eine Temperaturerhöhung von 0.75° die Verdoppelung von ![]() wieder aus, das wäre laut MODTRAN die Sensitivität. Viele Wissenschaftler kommen allerdings auf eine noch höhere Sensitivität von etwa 1°.

wieder aus, das wäre laut MODTRAN die Sensitivität. Viele Wissenschaftler kommen allerdings auf eine noch höhere Sensitivität von etwa 1°.

Diese Sensitivität wird aber — in gewisser Weise zu Recht — von den IPCC nahen Wissenschaftlern als die „reine ![]() -Sensitivität“ bezeichnet, weil dabei noch nicht der Einfluss des Wasserdampfes berücksichtigt ist. Da aber Wasserdampf ein noch stärkeres Treibhausgas ist, und durch die

-Sensitivität“ bezeichnet, weil dabei noch nicht der Einfluss des Wasserdampfes berücksichtigt ist. Da aber Wasserdampf ein noch stärkeres Treibhausgas ist, und durch die ![]() -bedingte Temperatur-Erhöhung mehr Wasserdampf erzeugt wird, wird in dieser „atomistischen“ Denkweise die

-bedingte Temperatur-Erhöhung mehr Wasserdampf erzeugt wird, wird in dieser „atomistischen“ Denkweise die ![]() Sensitivität dadurch effektiv verdoppelt. So ist es möglich, zu einer Sensitivität von 2° zu kommen, die man dann durch weitere Katastrophen-Szenarien wie das hypothetische Abschmelzen des Polareises noch willkürlich steigern kann. Völlig unberücksichtigt lassen sie dabei die Cumulus-Wolkenbildung, die ebenfalls durch Vergrößerung des Wasserdampfgehaltes verstärkt würde und die zur Reduzierung der einfallenden Energie führen würde, also zu einer starken negativen Rückkopplung. Allenfalls wird das Thema Wolken dadurch genutzt, indem argumentiert wird, dass die sehr hohen Zirrus-Wolken u.U. zu einer Verstärkung des Treibhauseffektes führen.

Sensitivität dadurch effektiv verdoppelt. So ist es möglich, zu einer Sensitivität von 2° zu kommen, die man dann durch weitere Katastrophen-Szenarien wie das hypothetische Abschmelzen des Polareises noch willkürlich steigern kann. Völlig unberücksichtigt lassen sie dabei die Cumulus-Wolkenbildung, die ebenfalls durch Vergrößerung des Wasserdampfgehaltes verstärkt würde und die zur Reduzierung der einfallenden Energie führen würde, also zu einer starken negativen Rückkopplung. Allenfalls wird das Thema Wolken dadurch genutzt, indem argumentiert wird, dass die sehr hohen Zirrus-Wolken u.U. zu einer Verstärkung des Treibhauseffektes führen.

Nach meiner Auffassung ist aber das Auseinanderreißen von gleichzeitig vorhandenem ![]() , Wolken und Wasserdampf bei der Berechnung der

, Wolken und Wasserdampf bei der Berechnung der ![]() Sensitivität nicht berechtigt. Werden alle Faktoren simultan berücksichtigt, führt das zu der oben genannten geringen Sensitivitität von 0.5°.

Sensitivität nicht berechtigt. Werden alle Faktoren simultan berücksichtigt, führt das zu der oben genannten geringen Sensitivitität von 0.5°.

Ja, aber die Temperatur nimmt doch zu?

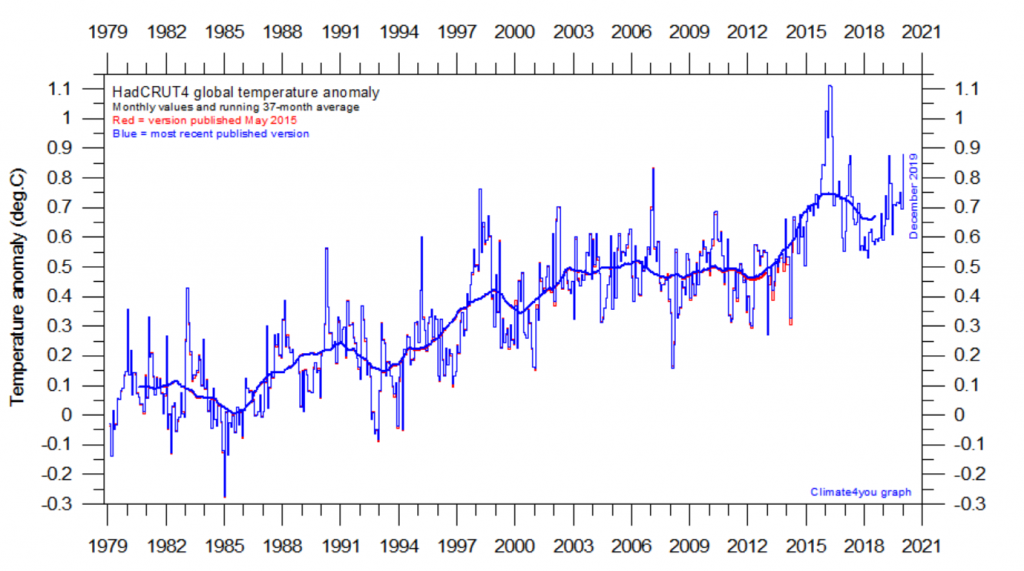

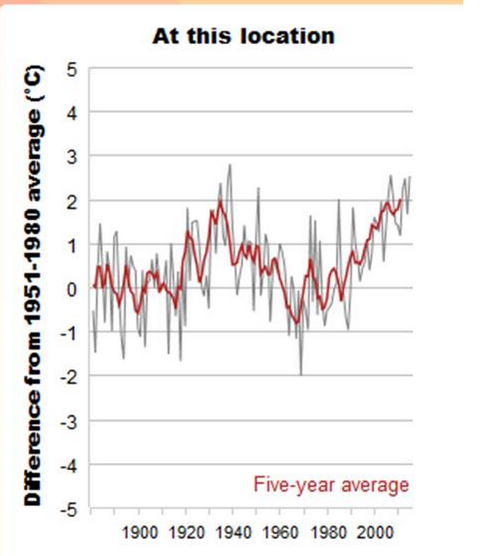

Es ist unbestritten, dass die mittlere Temperatur seit 1850 und insbesondere während der letzten 40 Jahre zugenommen hat.

Diese Zunahme wird ist der Klimadiskussion überwiegend dem Einfluss von ![]() zugeschrieben, der wie oben beschrieben, nur einen begrenzten Einfluss auf den Strahlungshaushalt der Erde hat.

zugeschrieben, der wie oben beschrieben, nur einen begrenzten Einfluss auf den Strahlungshaushalt der Erde hat.

Es gibt jedoch noch weitere Faktoren, die berücksichtigt werden müssen.

Das Dilemma der Albedo der Erde ist, dass

- Wolken unterschiedlicher Art in verschiedenen Höhen,

- reflektierende und streuende Aerosole,

- Einflüsse auf die Wolkenerzeugung, wie kosmische Strahlung und Magnetfelder,

- Oberflächen- und atmosphärische Eigenschaften als Folge von Schneebedeckung, Verstädterung, Landwirtschaft, Luftverschmutzung usw.,

- mögliche Rückkopplungseffekte der Temperatur über Wasserdampf und Wolkenbildung.

Eine umfassende Theorie des Einflusses der Erdalbedo wurde lange Zeit in der Mainstream-Diskussion vernachlässigt oder ignoriert. In den IPCC Berichten wird dieser Faktor als „schlecht verstanden“ zur Seite gelegt.

Aber es gibt einen anderen Ansatz.

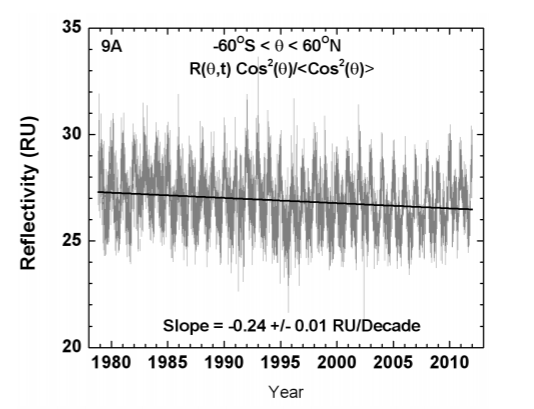

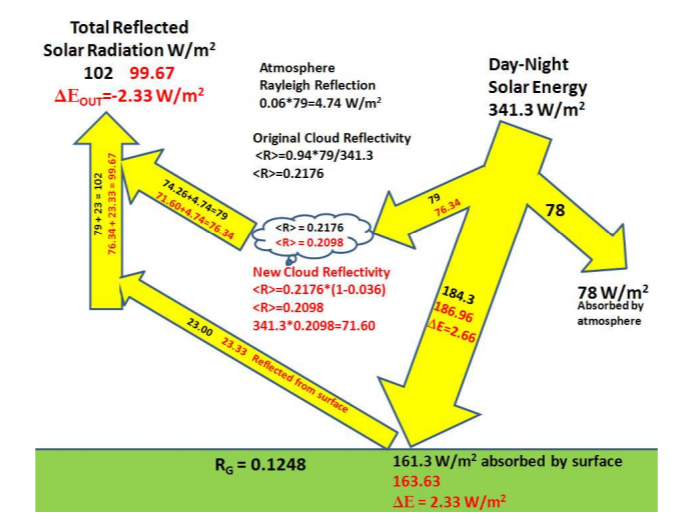

Diese sorgfältige kürzliche Analyse zeigt einen klaren, signifikanten Trend für die Reflexivität von 75% der gesamten Sonneneinstrahlung auf die Erde (Breitengrad -60…60 Grad, kleinere Einstrahlung und größere Albedo in Polnähe):

Die verringerte Wolken-Reflektivität vergrößert die von der Erde absorbierte und vermindert die reflektierte Lichtstrahlung:

Demnach ist die solare Einstrahlung in den 30 Jahren von 1980 bis 2010 um 2.33 ![]() gestiegen. Diese albedo-bedingte Zunahme innerhalb von 30 Jahren ist größer als die geschätzte Strahlungsantrieb von max. 2

gestiegen. Diese albedo-bedingte Zunahme innerhalb von 30 Jahren ist größer als die geschätzte Strahlungsantrieb von max. 2 ![]() der durch den Anstieg von

der durch den Anstieg von ![]() seit Beginn der Industrialisierung verursacht wurde. Schätzungsweise lassen sich 80% der Temperaturänderungen der letzten 40 Jahren auf die gemessenen Änderungen der Wolkenreflexivität zurückführen, und etwa 20% auf die postulierte Änderung infolge des gestiegenen

seit Beginn der Industrialisierung verursacht wurde. Schätzungsweise lassen sich 80% der Temperaturänderungen der letzten 40 Jahren auf die gemessenen Änderungen der Wolkenreflexivität zurückführen, und etwa 20% auf die postulierte Änderung infolge des gestiegenen ![]() -Gehalts der Atmosphäre. Dies bestätigt die Klimasensitivität von etwa 0.5° C.

-Gehalts der Atmosphäre. Dies bestätigt die Klimasensitivität von etwa 0.5° C.

Unser nächstes Thema beschäftigt sich mit der Frage:

Nehmen die klimabedingten Naturkatastrophen zu?

Dass die Natur nicht nur schön und gut sein kann, sondern von unvorstellbarer Brutalität, wird spätestens bei den ungewöhnlichen Ereignissen erkennbar, die man landläufig Naturkatastrophen nennt: Überschwemmungen, Dürreperioden, Waldbrände und Wirbelstürme. Diese Ereignisse stören das Bild von der „unberührten“ Natur, die in der Klimareligion als das Ideal der perfekten Welt gilt.

Von daher ist es nicht erstaunlich, dass bei mittlerweile jeder Naturkatastrophe, die irgendetwas mit Klima zu tun hat, der Chor der klima-gläubigen Medien diese Katastrophe in einen Sinnzusammenhang stellt mit dem „menschengemachten“ Klimawandel, um die Politiker und die ganze Gesellschaft „auf Kurs“ zu bringen.

Es darf nicht sein, was uns alle Geschichtsbücher übereinstimmend berichten, dass wir als Menschen es mit einer bisweilen lebensfeindlichen Natur zu tun haben, die hin und wieder ganz ohne unser Zutun aus mühsam aufgebauter Ordnung wieder unbeschreibliches Chaos und Verderben anrichtet, in der Umkehr des Schöpfungsgeschehens: „Am Anfang war Tohuwabohu – und Gott sprach: Es werde Licht…“.

Das Erstaunliche ist das außerordentlich kurze Gedächtnis der Klimagläubigen und die gezielte Einäugigkeit, wenn es darum geht, Superlative des Klima-Horrors zu erfinden. „Der heißeste Novembertag in Phoenix seit Beginn der Wetteraufzeichnungen„, also einer einzelnen Stadt bei gleichzeitiger sechst-größter Schneebedeckung der ganzen Nordhalbkugel seit 60 Jahren, was allerdings verschwiegen wird.

Die entscheidende Frage ist aber nicht, ob es extreme und katastrophale Ereignisse gibt, sondern ob es einen eindeutigen Trend zu schlimmeren, gravierenderen Ereignissen gibt. Dieser Frage wollen wir nachgehen.

Ich möchte hier die Ereignisse über einen längen Zeitraum betrachten. Das erscheint mir als das einzige legitime Vorgehen. Grundsätzlich ist es sinnlos, angesichts so großer Schwankungen wie sie bei Wetterereignissen vorkommen, bei einem untersuchten Zeitraum von weniger als 30 Jahren von „klimarelevant“ zu sprechen.

Selbst beim offiziellen Bericht des Weltklimarats wird hinsichtlich von Naturereignissen gesagt, dass es bislang keinen Nachweis gibt, dass diese in einem Zusammenhang mit dem höheren ![]() -Gehalt stehen.

-Gehalt stehen.

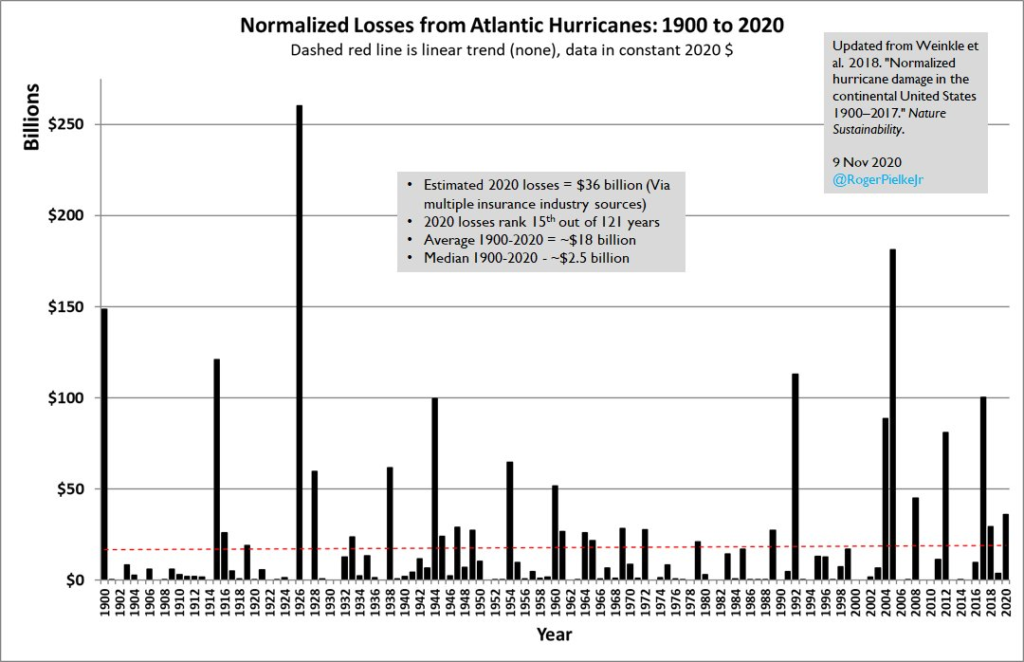

Beginnen möchte ich mit den Schäden der atlantischen Wirbelstürme während der letzten 100 Jahre. Trotz starken Bevölkerungswachstums und vielfach größerer Zahl von zerstörbaren Gütern gibt es während der letzten 100 Jahre keinen Trend zu stärker zerstörerischen Wirbelstürmen.

Finanzielle Schäden aufgrund von Atlantischen Wirbelstürmen seit 100 Jahren

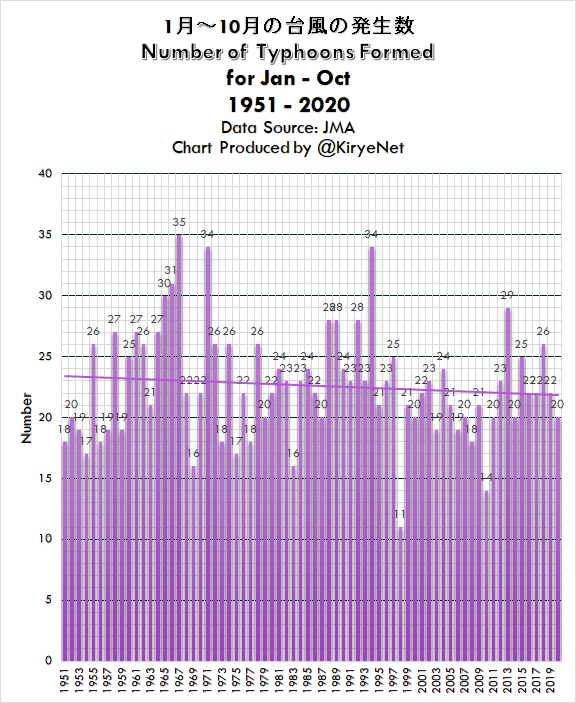

Bei den Taifun-Wirbelstürmen in oder um Japan ist es ähnlich. Hier kann man sogar von einem abnehmenden Trend reden.

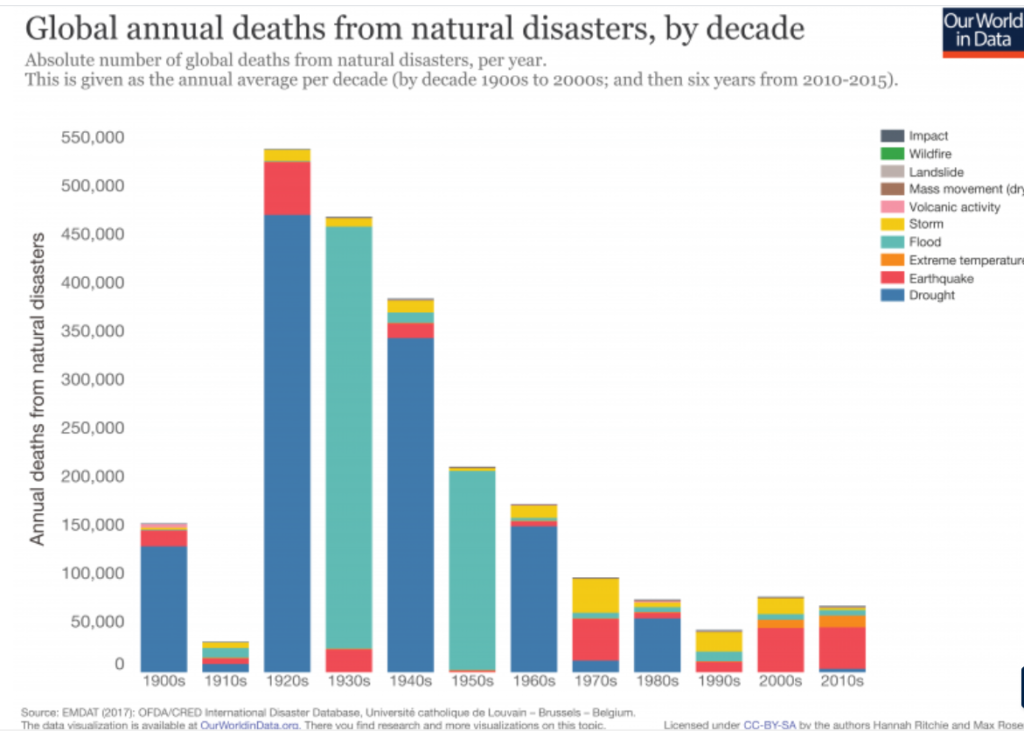

Die Todesfälle bei Naturkatastrophen haben im Laufe der letzten 100 Jahre dramatisch abgenommen. Das ist unmittelbar darauf zurückzuführen, dass Menschen durch die Nutzung von überwiegend fossiler Energie wohlhabender wurden, und sich vor den Widrigkeiten der Natur, seien es Wetterereignisse oder andere Katastrophen, besser als vorher schützen konnten.

Abschmelzen der Pole?

Zu den künftig möglichen Naturkatastrophen gehört wegen des daraus folgenden Anstiegs des Meeresspiegels das befürchtete Abschmelzen des Eises der Polkappen sowie des Grönlandeises.

Grundsätzlich ist hierbei zu unterscheiden, ob es sich um Meereis oder um Eis auf dem Land handelt. Abschmelzen von Meereis ist Meeresspiegel-neutral, wenn das Eis auf dem Wasser schwimmt. Also ist die die Frage des Nordpol-Eises für das Thema Meeresspiegel-Anstieg irrelevant.

Wegen des Grönlandeises ist allerdings die Entwicklung des nordischen Polarklimas für den Meeresspiegel relevant. Eine Erwärmung während der der letzten 30-40 Jahre ist zweifellos zu verzeichnen. Es fällt allerdings auf, dass die meisten Analysen des nördlichen Polarklimas erst 1978 oder später beginnen. Kann es sein, dass das damit zu tun hat, dass die Erwärmung der letzten 40 Jahre ungefähr gleich groß war wie die Abkühlung während der 40 Jahre davor?

Die Temperaturentwicklung auf Spitzbergen (Svalbard) zeigt dies deutlich:

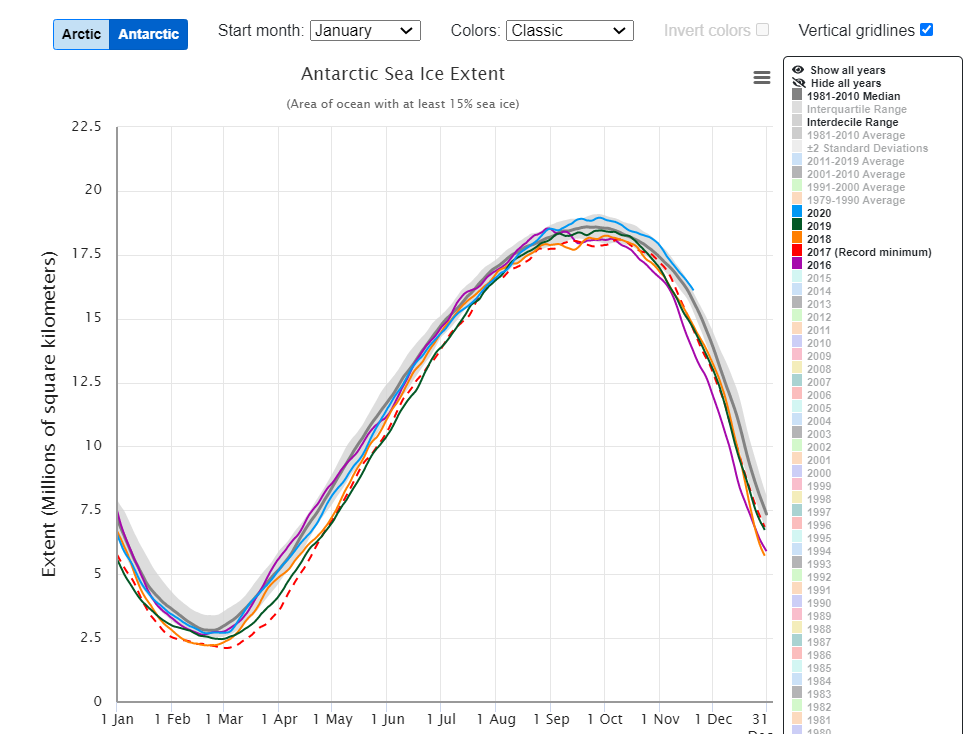

Bei der Betrachtung des Eises der Antarktis wird als Indikator für den Zustand der Gesamtvereisung die Ausbreitung des Meer-Eises gemessen, weil es mit Satelliten leicht zu messen kann (Stand 20.11.2020):

Die Graphik zeigt, dass die Werte der vergangenen 5 Jahr sich alle in der Nähe des jeweiligen langjährigen jahreszeitbezogenen Mittelwertes befinden, und dass sich insbesondere dieses Jahr die Meer-Eis-Ausbreitung deutlich über dem langjährigen Mittelwert befindet. Von Abschmelzen kann also überhaupt Rede sein.

Dazu kommt, dass über der Antarktis der Treibhauseffekt negativ ist, d.h. die Antarktis ist so kalt, dass die ![]() Abstrahltemperatur von -53° C meist größer ist als die Temperatur des Eises. Daher bewirkt eine Zunahme des

Abstrahltemperatur von -53° C meist größer ist als die Temperatur des Eises. Daher bewirkt eine Zunahme des ![]() in der Atmosphäre eine leicht verstärkte Infrarot-Abstrahlung, also eine leichte Temperatur-Absenkung.

in der Atmosphäre eine leicht verstärkte Infrarot-Abstrahlung, also eine leichte Temperatur-Absenkung.

Bislang haben wir uns mit der Analyse beschäftigt, mit der Hinterfragung der wissenschaftlichen Voraussetzungen des Klimageschehens. Nun sind aber die Maßnahmen zur Vermeidung der vermeintlichen Gefahr eines weiteren Anstiegs von ![]() schon seit 20 Jahren im Gange. Daher widmen wir uns jetzt der Energiewende und ihren Folgen.

schon seit 20 Jahren im Gange. Daher widmen wir uns jetzt der Energiewende und ihren Folgen.

Der Preis der Energiewende

Es wird in der Klimadiskussion viel geredet über den Preis, den wir und künftige Generationen finanziell und in Form von Lebensqualität „bezahlen“ müssen, wenn wir einfach so weitermachen wie bisher.

Deutlich weniger wird darüber geredet, welchen Preis wir für die Alternativen bezahlen, die aktuell als „Lösung“ des „Klimawandels infolge des Treibhauseffektes“ politisch propagiert werden.

Konkretisierung der Energiewende

Was wird aktuell unter Energiewende verstanden? Es ist ein Bündel von bereits begonnenen oder geplanten Maßnahmen, die das Ziel haben, letztlich unsere komplette Energieversorgung angeblich „nachhaltig“ zu gestalten:

- Abschaltung von Kohle- und Kernkraftwerken, letztlich auch Gaskraftwerken

- Energiegewinnung durch Wind- und Solarenergie

- Treibstoffgewinnung durch Biotreibstoffe oder „grünem“ Wasserstoff

- Elektromobilität

- Einsparung von Heizkosten durch Dämmung und effizientere Gasheizungen

Machbarkeit der Energiewende

Es muss — eigentlich längst vor der Umsetzung — die Frage gestellt werden, inwieweit sich dieses Konzept unter den gegebenen Randbedingungen umsetzen lässt. Dazu hat der langjährige Leiter des Münchener IFO-Instituts, Prof. Werner Sinn, Ende 2017 einen richtungsweisenden Vortrag gehalten, der nach wie vor aktuell ist.

Eines der zentralen Probleme von Wind- und Solarenergie ist die Speicherung von elektrischer Energie aufgrund der unzuverlässigen Erzeugung. Dabei ist das Hauptproblem nicht die kurzfristige Speicherung, die ggf. mit einem „Smart Grid“ und/oder Batterien erfolgen kann, sondern die langfristige, saisonale Speicherung. Diese kann mit bekannter Technologie nur in Speicherkraftwerken oder mit Wasserstoff oder Methan erfolgen.

Beide Konzepte haben ihre eigenen Probleme:

- Deutschland verfügt überhaupt nicht über Standorte, die für weitere Pumpspeicherkraftwerke geeignet wären.

- Der Umweg über die Methan-Speicherung hat einen so niedrigen Wirkungsgrad von etwa 25%, dass eine wirtschaftliche Nutzung in absehbarer Zeit nicht in Frage kommt. Der Methanpreis aus solarer oder Windenergie wäre um einen Faktor 10 über dem aktuellen Weltmarktpreis. Zudem ist der

Ausstoß aus der Herstellung der Solarmodule bei Methan-Speicherung genauso hoch wie bei Gaskraftwerken.

Ausstoß aus der Herstellung der Solarmodule bei Methan-Speicherung genauso hoch wie bei Gaskraftwerken. - Die Wasserstoff-Speicherung ist vom Wirkungsgrad mit 40-50% etwas besser, aber Transport, Lagerung und Nutzung von Wasserstoff sind sehr viel aufwändiger und sind zum Teil noch im Forschungsstadium.

- Die Brennstoffzellentechnologie zur direkten Nutzung von Wasserstoff ist aktuell wegen der notwendigen teuren Platin-Katalysatoren nur bei speziellen Anwendungen eine wirtschaftliche Option.

Das führt zu dem Ergebnis, dass selbst unter sehr optimistischen Annahmen ein maximaler Anteil von 50% durch Wind- und Solarenergie sinnvoll realisierbar ist.

Die Ineffizienz der Energiewende

Sowohl die Stromgewinnung aus Solarenergie wie auch aus Windenergie hängen seit über 20 Jahren am Tropf der Subventionen. Diese müssen von den anderen, überwiegend den kleinen privaten Stromabnehmern bezahlt werden.

Warum das so ist, wird schnell offensichtlich, wenn man die Ausbeute bei den deutschen Windkraftanlagen betrachtet:

Über die Hälfte des Jahres erbringen alle Anlagen zusammen weniger als 20% ihrer Nennleistung. Nur während 15% der Zeit leisten sie mehr als ihre halbe Nennleistung. Im Durchschnitt leisten sie also höchstens ![]() ihrer installierten Leistung, und diese Leistung ist nicht bedarfsorientiert, sondern fällt an, wenn zufällig der Wind weht.

ihrer installierten Leistung, und diese Leistung ist nicht bedarfsorientiert, sondern fällt an, wenn zufällig der Wind weht.

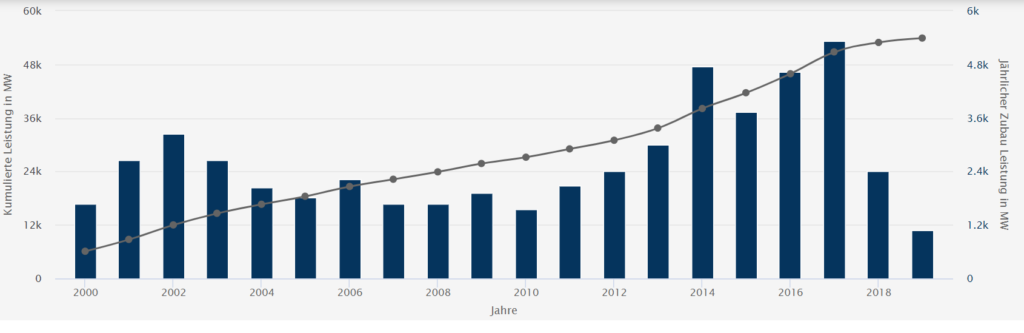

Aufgrund der Ankündigung, dass ab dem Jahr 2020, also nach 20 Jahren Förderung, keine Subventionen mehr für Windenergie ausgegeben werden, sind die Investitionen seit 2018 rapide zurückgegangen, sodass damit zu rechnen ist, dass in den kommenden Jahren, wenn mehr und mehr alte Windkraftwerke angesichts der kurzen Lebensdauer von etwa 20 Jahren, wieder abgebaut werden, unter normalen Marktbedingungen die gesamte installierte Leistung zurückgehen wird:

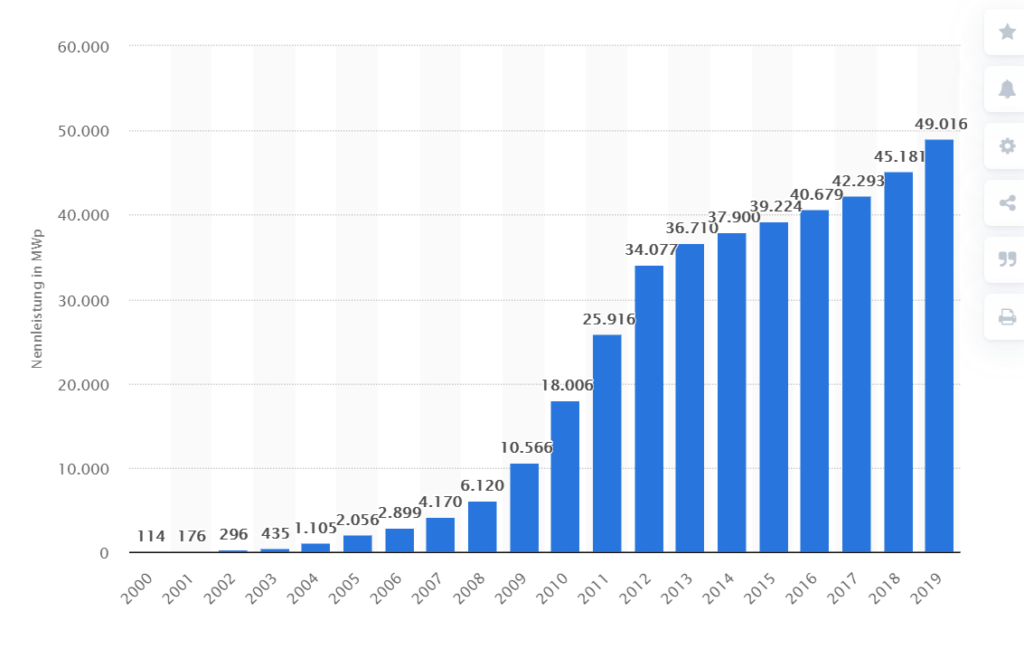

Bei der Photovoltaik ist die Phase des schnellen Ausbaus offenbar ebenfalls vorbei, die größten Jahresinvestitionen mit bis zu ![]() pro Jahr waren im Jahr 2012, das ist danach dramatisch auf

pro Jahr waren im Jahr 2012, das ist danach dramatisch auf ![]() pro Jahr zurückgegangen, zuletzt

pro Jahr zurückgegangen, zuletzt ![]() pro Jahr.

pro Jahr.

Aufgrund der geringen Sonnenscheindauer in Deutschland und des Wirkungsgrades der Anlagen erreichen ist die Energieausbeute nur 10.7% der installierten Leistung, im Jahr 2019 waren es 46 TWh, was etwa 8.2% des Gesamtstromverbrauchs bedeutet.

Die aktuelle Situation lässt sich exemplarisch an dem Tesla-Werk in Brandenburg beschreiben. In der Ausschreibungsphase wurde damit geworben, dass das Werk in Brandenburg vollständig mit nachhaltiger Wind- und Sonnenenergie betrieben würde – so wie es bei dem Tesla-Werk in Nevada geplant ist. In der deutschen Presse gab es wahre Begeisterungsstürme. Nevada liegt allerdings in der Wüste, es ist eine der heißesten und wolkenärmsten Gegenden der USA mit 3838 Sonnenstunden im Jahr.

Und lässt sich recht einfach ermitteln, dass die Anzahl der Sonnenstunden in Brandenburg mit 1715 nicht einmal die Hälfte derer in Nevada beträgt. Als dann die konkreten Pläne für das Tesla-Werk eingereicht wurden, war kein Solardach für das Werk vorgesehen. Offenbar hat Elon Musk alles genau durchgerechnet und festgestellt, dass sich die „nachhaltige“ Energie in Deutschland für ihn nicht rechnet, zumal er selbst im sonnenreichen Nevada das Solardach noch lange nicht fertig gebaut hat.

Nebenwirkungen der Energiewende

Es wird in der Öffentlichkeit weithin der Eindruck vermittelt, dass die „neuen“ Technologien der Energiewende auch Umweltverträglichkeit bedeuten. Mit der Einführung dieser Technologien hat sich allerdings gezeigt, dass es zu teilweise vorhersehbaren, gravierenden „Kollisionen“ mit dem Schutz der Umwelt und der Bewahrung der Schöpfung kommt.

Der seit über 50 Jahren in Umweltfragen engagierte, renommierte Biologe Dr. Wolfgang Epple hat sich u.a. sehr intensiv mit den Nebenwirkungen der Windenergiegewinnung und Bio-Treibstoffen, zwei wesentlichen Standbeinen der Energiewende auseinandergesetzt:

- Flächenverbrauch (in Wäldern z.B. 600 Bäume pro Windanlage, bzw. etwa 1 ha Fläche, davon 0.5 ha dauerhaft). Allerdings bildet die Frage des Flächenverbrauchs die Problematik des Verdrängens von Wildtieren und Störung des ökologischen Gleichgewichts nur ungenügend ab.

- Windananlagen als tödliche Fallen für Vögel und Insekten

- Gesundheitliche Beeinträchtigung durch den Infraschall von Windanlagen

- Beeinträchtigung der Biodiversität durch Monokulturen

Zu ähnlichen Schlußfolgerungen kommt Michael Shellenberger in seinem Buch „Abocalypse Never“. Shellenberger, der über viele Jahre die regenerativen Energien im „energetischen Musterland“ Kalifornien propagiert hat, resümiert: „Jetzt, nachdem wir festgestellt haben, dass die erneuerbaren Energien den Planeten nicht retten können, sollten wir den erneuerbaren Energien nicht erlauben, den Planeten zu zerstören:“

Ungelöste Recycling-Probleme bei Windkraftanlagen

Zu den Nebenwirkungen der Energiewende zählen auch die ungelösten Entsorgungsprobleme. Sowohl Solarzellen als auch Windkraftanlagen haben nur eine sehr begrenzte Lebensdauer von etwas 20-25 Jahren. Daher fallen große Mengen an Abfall von ausgedienten Anlagen an. Während es für Solarzellen Entsorgungskonzepte gibt, sind Rotorblätter von Windkraftanlagen nicht recyclebar. In den kommenden Jahren fallen voraussichtlich 1.35 Millionen Tonnen Giftmüll bei der Entsorgung verschrotteter Windkraft-Rotorblätter an, für die es nach einem Bericht des ZDF bislang keine Lösung gibt.

Den Hauptpreis bezahlen die Ärmsten der Armen

Die deutsche Regierung plant, innerhalb der nächsten 4 Jahre 40 Milliarden auszugeben, um eine Reduzierung der CO2-Emissionen zu erreichen. Damit kann hypothetisch der globale Anstieg der Durchschnittstemperatur um 0.00018 Grad in hundert Jahren vermindert werden – ein unmessbar kleiner Erfolg bei so gigantischen Kosten. Würde derselbe Betrag zur Vorsorge gegen Tuberkulose in Entwicklungsländern eingesetzt, könnten absehbar mehr als 10 Millionen Menschen gerettet werden.

In Deutschland gibt es aufgrund der in Folge der Energiewende exorbitanten Kosten für Strom, Öl und Gas mittlerweile über 300.000 Menschen, denen der Strom abgestellt wurde, weil sie die Stromrechnung nicht mehr bezahlen konnten, und die Bundesregierung verweigert genauere Untersuchungen darüber. Das bis vor kurzem unbekannte Wort „Energiearmut“ ist nun Bestandteil der deutschen Sprache.

Zusammenfassung der wissenschaftlichen Bestandsaufnahme

- Grundsätzlich ist es richtig, dass eine Zunahme des

Gehalts der Atmosphäre eine leichte Temperaturzunahme bewirken kann, das kann aber bis heute nicht zweifelsfrei nachgewiesen werden

Gehalts der Atmosphäre eine leichte Temperaturzunahme bewirken kann, das kann aber bis heute nicht zweifelsfrei nachgewiesen werden - Diese Temperaturzunahme von etwa 0.5° bei Verdoppelung der

-Gehalts ist nach dem Stand der Wissenschaft keineswegs von katastrophalem Ausmaß, sie liegt weit unter den Grenzwerten des Pariser Klimaabkommens

-Gehalts ist nach dem Stand der Wissenschaft keineswegs von katastrophalem Ausmaß, sie liegt weit unter den Grenzwerten des Pariser Klimaabkommens - Die stark zugenommene Begrünung der Erde ist die sichtbarste positive Auswirkung der Zunahme des

Gehalts

Gehalts - Die seriösen Wissenschaftler sind sich darin einig, dass die mit Klima und Wetter zusammenhängenden Naturkatastrophen im Laufe der letzten 100 Jahre nicht zugenommen, und in ihren Auswirkungen dramatisch abgenommen haben.

- Die als Lösung des Klimaproblems seit 20 Jahren vorangetriebene Energiewende kann aufgrund physikalischer Grenzen und exorbitanter Kosten das vorgenommene Ziel nicht erreichen.

- Die Nebenwirkungen der Energiewende in Form von Energie-Armut, eingeschränkter Lebensqualität, Zerstörung der Umwelt, Einschränkungen der Freiheit sind so dramatisch, dass vor einem „weiter so“ nur gewarnt werden kann.

Der letzte Teil des heutigen Vortrags ordnet das Phänomen der Klimareligion historisch und philosophisch ein. Für mich stellt es sich so dar:

Die Klimareligion, ein Glaubensbekenntnis der Postmoderne

Die folgenden Überlegungen sind inspiriert durch den Vortrag „Political correctness and Postmodernism“ von Prof. Jordan Peterson, Teile sind daraus sinngemäß oder wörtlich übernommen (gekennzeichnet durch Kursivschrift). Um das Gesamtbild darzustellen zu können, verzichte ich bewusst auf Differenzierungen, die in einer ausführlicheren Diskussion sinnvoll wären.

Um die Klimareligion als eine Konfession oder Sekte der Postmoderne zu verstehen, müssen wir ein Stück zurückblicken. Wir erleben die Klimareligion als eine Ausprägung der sogenannten politischen Korrektheit. Das ist ein Bündel von Anschauungen und Überzeugungen, die seit Jahrzehnten als vermeintlicher „gesellschaftlicher Konsens“ vorangetrieben werden, und denen zu widersprechen zusehends schwieriger wird und nicht selten die gesellschaftliche Ächtung bedeutet. Zu diesem vermeintlichen Konsens, gehört die Klimareligion, deren fragwürdiges Bekenntnis, wie oben ausgeführt, stark vereinfacht darin besteht, dass der Mensch, genauer die jeweils anderen Menschen, letztendlich ein Schädling des ansonsten „guten“ Planeten Erde sei.

Die „politische Korrektheit“ ist ein paradoxes Gemisch aus der Postmoderne, die als eine Form der Philosophie und Literaturkritik entstanden ist, und dem Marxismus oder Neomarxismus. Diese postmoderne philosophische Revolution ist wesentlich geprägt durch zwei französische Intellektuelle, Jacqes Derrida, und Michel Foucault. Derrida’s Thema war die Literaturkritik, deren zentrales Element der sogenannten „Dekonstruktion“ sich mittlerweile in alle Sprach- und Sozialwissenschaften ausgebreitet hat. Das zentrale Argument der postmodernen Dekonstruktion ist die im Prinzip richtige Feststellung:

Es gibt unendlich viele Möglichkeiten, jede endliche Menge von Phänomenen zu interpretieren. Das ist tatsächlich wahr. Dieser Umstand bereitet z.B. in der digitalen Bildverarbeitung und künstlichen Intelligenz große Probleme, die reale Welt richtig zu interpretieren. Denn es stellt sich heraus, dass die Welt so komplex ist, dass ihre Wahrnehmung technisch gesehen praktisch unmöglich erscheint. Die Konsequenz der Postmodernen Philosophie daraus ist die These, dass keine dieser Interpretationen gegenüber anderen bevorzugt werden sollte.

Für die Postmodernen Philosophen und ihre Nachfolger folgt aus diesem grundsätzlichen Problem, dass man es dazu benutzen kann, jede konkrete Interpretation der Wirklichkeit – der anderen – anzugreifen. In der Theologie gibt es eine ähnliche Entwicklung mit der historisch-kritischen Methode schon seit dem 19. Jahrhundert, und sie führte zu einer weitgehenden Relativierung und Beliebigkeit in der kirchlichen Verkündigung und dem damit verbundenen massiven Glaubensabfall.

Der inhaltliche Fehler der postmodernen Philosophie

Der grundlegende Fehler der Postmodernen liegt darin, dass es zwar eine sehr große Zahl potenzieller Interpretationen der Welt gibt, dass diese Interpretationen der Welt aber nicht alle mit dem Leben verträglich sind. Dabei sind Interpretationen nicht als distanzierte theoretische Betrachtungen zu verstehen, sondern als die Wahrnehmung, die zum aktiven Handeln in der Welt führt.

Die schlimmsten Fehlinterpretationen der Wirklichkeit führen zum Tod – eine schreckliche Lösung des Interpretationsproblems. Deswegen schützen wir unsere Kinder vor solchen gravierenden Fehlinterpretationen, solange sie die Wirklichkeit noch nicht selbst angemessen beurteilen können. Ob Benutzung scharfer Messer, giftige Beeren oder Pilze, oder der Straßenverkehr – erst durch komplexe Lernprozesse lernen wir die mit dem Leben verträgliche Interpretation der Wirklichkeit.

Damit ergibt sich die erste Gruppe von Einschränkungen: Die Interpretationen der Welt sollen so weit wie möglich vor übermäßigem Leiden und Tod schützen. Dies sollte jedem einleuchten, der nicht in die suizidale Richtung zielt.

Das Zusammenleben mit anderen – Kooperation und Konkurrenz – schränken die zulässigen Interpretationen weiter ein. Vor allem, wenn man bedenkt, dass man nicht nur einmal kooperieren und mit den Menschen konkurrieren muss, sondern dass man mit denselben Menschen oft viele Male in vielen verschiedenen Kontexten kooperieren und konkurrieren muss.

Man will also nicht zu viel leiden und nicht sterben, und man will mit den Menschen zusammenarbeiten und mit ihnen konkurrieren können. Und Sie wollen das über lange Zeiträume tun können, und dann wollen Sie es vielleicht auch mit einem Ziel vor Augen tun. Dadurch müssen wir unsere Interpretation einschränken, so dass, wenn wir sie in der Welt umsetzen, die Wahrscheinlichkeit steigt, dass das, was wir anstreben, auch eintritt.

Der Philosoph Immanuel Kant hat dies mit dem „kategorischen Imperativ“ ausgedrückt: Handle so, als ob die Sache, die Du tust, von allen gemacht wird. Und der Entwicklungspsychologe Piaget hat es weiter ausgeführt: Lebe so, als ob das, was Du tun wirst, immer wieder wiederholt wird, und zwar so, dass es aufwärts statt abwärts geht. Es gibt also enorme Einschränkungen in der Art und Weise, wie wir die Welt aus jeder sinnvollen realistischen Perspektive interpretieren können. Die Kritik der Postmodernen, dass es unendlich viele Interpretationen und als Konsequenz moralische Beliebigkeit gibt, zerfällt also bei näherer Betrachtung.

Die merkwürdige Allianz der Postmoderne mit dem Marxismus

Dazu kommt die auffällige Merkwürdigkeit, dass die Postmodernen die Lösung aller Probleme im Marxismus sehen, dass die Welt am besten durch die Linse von Unterdrückern und Unterdrückten betrachtet wird. Weil es so ist, und wenn man zum Beispiel Derrida oder Foucault liest, und die Geistesgeschichte der postmodernen Bewegung betrachtet, die sich in den 1970er Jahren schnell ausbreitete, stellt man fest, dass es kein Geheimnis ist, dass die Postmoderne aus einem zugrunde liegenden marxistischen Rahmen heraus entstanden ist. Diesen haben sie nie aufgegeben, sie haben ihn lediglich modifiziert.

Der Klassenkampf „Proletariat gegen Bourgeoisie“ ging nahtlos über in den Kampf einer Identitätsgruppe gegen die andere: Frauen gegen Männer, Homosexuelle etc. gegen Heterosexuelle, Farbige gegen Weiße, Einwanderer gegen Einheimische, Moslems gegen Christen, Progressive gegen Konservative.

Es ist immer wieder die gleiche Inszenierung: gefühlten Unterdrückte gegen vermeintliche Unterdrücker, immer derselbe Taschenspielertrick.

Bündnis der Postmoderne mit dem Marxismus

Wie kommt es also, dass sich Postmoderne, die angeblich keine Interpretation bevorzugen, mit dem Marxismus verbündet haben?

Die wohlwollende Antwort könnte sein: Die Postmodernisten und die Radikalen, die die politisch korrekte Bewegung vorantreiben, sind eigentlich aufrichtig in ihrem Wunsch, den Unterdrückten zu helfen. Auch wenn es keine bevorzugte Lebensinterpretation gibt, können wir immer noch wie anständige Menschen handeln und versuchen, uns um Menschen zu kümmern, die weniger Glück haben als wir.

Intellektuell ist das allerdings ein schlechtes Argument, weil es den Widerspruch der Postmoderne zwischen unendlich vielen Interpretationen und der Bevorzugung der marxistischen Interpretation nicht auflöst. Mangelnder Respekt vor Kohärenz und Logik ist die Schwäche der Postmodernen.

Das entscheidende Problem dieser Theorie war aber, dass Ende der 60er Jahre Beweise der mörderischen Taten des maoistischen China, der stalinistischen und poststalinistischen Sowjetunion bekannt wurden: Abscheuliche politische Praktiken in einem solchen Ausmaß und einer solchen Unbestreitbarkeit, dass selbst die französischen Intellektuellen zugeben mussten, dass etwas nicht stimmte.

Und so wurde es ihnen Ende der 1960er Jahre unmöglich, sich mit den Unterdrückten zu identifizieren und gleichzeitig zu behaupten, dass man sich an die Grundsätze des Marxismus als einer funktionierenden wirtschaftlichen und politischen Doktrin halte. Alexander Solschenizyn hat schließlich Mitte der 70er Jahre mit seinem „Archipel Gulag“ den sozialistischen Terror endgültig entlarvt.

Damit ist das postmoderne Argument unglaubwürdig und disqualifiziert, dass Mitgefühl das Motiv für die Allianz zwischen Postmoderne und Marxismus sei. Weil sie die historische Realität ignorieren, dass die Doktrinen, die sie in die Praxis umzusetzen versuchen, mörderisch jenseits aller Vorstellungskraft waren – kann ich das Argument nicht akzeptieren, dass es Mitgefühl ist, das sie angeblich antreibt.

Die Klimareligion und die Grünen

Wie reiht sich nun die Klimareligion in dieses marxistische Konzept ein? Hier wird die falsche Illusion aufgebaut, dass eine „unberührte Natur“ pauschal als gut idealisiert wird. Diese wird in deren Sichtweise vom Menschen unterdrückt, ausgebeutet und zerstört. Damit wird der marxistische „Klassenkampf“ ausgeweitet als Kampfansage an alle Menschen, weil jeder einzelne vermeintlich zur Unterdrückung und Zerstörung der „guten“ Natur beiträgt. Der Mensch, sofern er überhaupt ein Lebensrecht hat, wage sich nicht, dem Schöpfungsauftrag „Macht euch die Erde untertan“ nachzukommen, sondern ordne sich der Natur unter. Das erklärt den ansonsten unerhörten Widerspruch dieser Aktivisten, dass sie sich in Großdemonstrationen für „Juchtenkäfer“ einsetzen, aber keine Skrupel zeigen, wenn in Spätabtreibungen lebensfähige Kinder umgebracht werden.

Das ![]() erweist sich für diese Aktivisten als idealer „Verbündeter“. Es wirkt grenzüberschreitend, seine Erzeugung ist bislang untrennbar mit dem Erzeugen von Energie als Grundlage von Gesundheit und Wohlstand verbunden. Seine Verteufelung erschließt einen Machthebel über die ganze Welt. Das Beste aber: Sie machen damit Angst.

erweist sich für diese Aktivisten als idealer „Verbündeter“. Es wirkt grenzüberschreitend, seine Erzeugung ist bislang untrennbar mit dem Erzeugen von Energie als Grundlage von Gesundheit und Wohlstand verbunden. Seine Verteufelung erschließt einen Machthebel über die ganze Welt. Das Beste aber: Sie machen damit Angst.

Dazu kommt, dass speziell in Deutschland der Beginn der „grünen“ Bewegung direkt gekoppelt war mit dem Kampfansage der marxistischen Linken gegen die Atomkraft, die als Verkörperung des kapitalistischen Feindbildes gesehen wurde. Der Widerstand gegen die Atomkraft diente insbesondere auch dazu, die durch die linksradikalen Terroristen der RAF gespaltene und verwirrte linke Bewegung wieder auf ein gemeinsames Ziel zu lenken. Die marxistische Fixierung der Bewegung stieß diejenigen, die sich ursprünglich durch Leidenschaft für den Naturschutz und Sorge um die Schöpfung der grünen Partei anschlossen, vor den Kopf. Die „aufrichtigen Naturschützer“ wie z.B. Dr. Herbert Gruhl, waren bald in der Minderheit und verließen die Partei. Seither ist die Partei durch hartgesottene Stalinisten („Fundis“) und postmoderne „Identitätspolitiker“ verschiedener Ausprägung („Realos“) charakterisiert. Ähnlich ging es einem der Mitgründer von Greenpeace, Patrick Moore, als er erleben musste, dass sich die Aktivitäten von Greenpeace zunehmend gegen die Fundamente der Industriegesellschaft richteten, die unser aller Gesundheit und Wohlstand sichert. Mit dem Kampf gegen die Atomkraft sägen die Vertreter der Klimareligion am zweiten möglichen Pfeiler der Energiegewinnung, die zudem völlig ![]() neutral ist, und in der Geschichte der Energiegewinnung die Abstand wenigsten Opfer, bezogen auf die erzeugte Energie, zu beklagen hat.

neutral ist, und in der Geschichte der Energiegewinnung die Abstand wenigsten Opfer, bezogen auf die erzeugte Energie, zu beklagen hat.

Die wahre Movitation der Postmoderne – Missgunst und Verbitterung

Was aber treibt die marxistische Postmoderne und speziell die Klimareligion an? Den Schlüssel zum Verständnis finden wir bei Friedrich Nietzsche – vor 150 Jahren.

Er schrieb in „Wille zur Macht“, dass die nihilistischen Doktrinen, die in der Folge nach der Zerstörung der theologischen und philosophischen Substruktur des Westens auftauchen würden, die er mit der Offenbarung des Todes Gottes in Verbindung brachte, politische Katastrophen hervorrufen würden. Und er sprach ausdrücklich vom Kommunismus, das war um 1850-1860 – unglaublich – und dass dieser im 20. Jahrhundert zig bis hunderte von Millionen Menschen töten würde.

Zur Motivation führt Nietzsche im Gedicht „Von den Taranteln“ sehr treffend aus:

Prediger der Gleichheit! Taranteln seid ihr mir und versteckte Rachsüchtige!

»Rache wollen wir üben und Beschimpfung an allen, die uns nicht gleich sind« – so geloben sich die Tarantel-Herzen.

Ihr Prediger der Gleichheit, der Tyrannen-Wahnsinn der Ohnmacht schreit also aus euch nach »Gleichheit«: eure heimlichsten Tyrannen-Gelüste vermummen sich also in Tugend-Worte!

Das ist also der Wesenskern des „Gleichheitswahns“, der alle Unterschiede nivellieren möchte und überall „verborgene“ Macht- und Ausbeutungsstrukturen wittert. Dies erklärt die paradoxen, die perversen Paradoxien, die der ansonsten unverständlichen Vereinigung zwischen den Postmodernen und den Marxisten zugrunde liegen. Die von ihnen selbst angebotene Erklärung ist Mitgefühl, aber die Lehren, deren Umsetzung im Dienste der Menschheit propagiert werden, haben sich wie kaum eine andere Doktrin mörderisch und tyrannisch jenseits aller menschlichen Vorstellungskraft erwiesen.

In ihrer Welt gibt es nichts als Macht. Sie haben kein Interesse an einer ergebnisoffenen Diskussion, der Andersdenkende muß zum Schweigen gebracht werden, am besten endgültig.

Um eine wissenschaftliche Klimatagung zu verhindern, haben bekannte Pressevertreter und Politiker sich mit radikalen Antifa-Gruppen verbündet, um dem Tagungshotel mit Gewalt zu drohen, was dann auch zur Kündigung des Mietvertrages führte.

Alle postmodernen Fraktionen werden von Missgunst und Bitterkeit angetrieben.

Greta Thunbergs Schlachtruf ist „Ihr habt meine Träume und meine Kindheit gestohlen“, ihr damit verbundener Gesichtsausdruck voller Missgunst und Bitterkeit spricht Bände – sie selbst gehört übrigens zu den Privilegierten dieser Welt.

Egal, wie gut es mir geht, ich finde immer jemanden, der mehr hat oder mehr geachtet ist, und die Güter sind ungleich verteilt. Ich stelle fest, dass diese Verteilung auf einer bestimmten Interpretation der Wirklichkeit beruht, die in aller Regel das Ergebnis eines langen und auch immer wieder zu Recht umstrittenen politischen und gesellschaftlichen Meinungsbildungsprozesses ist, z.B. auf dem freien Wettbewerb und der Belohnung der Fleißigen, oder der Nutzung natürlicher Resourcen wie Kohle und Öl, dann kann ich als Postmoderner diese Verteilungshierarchie dadurch demolieren, indem ich die Gültigkeit dieser – gewachsenen – Interpretation untergrabe. Damit kann ich jegliche Macht, Autorität oder Privileg in Frage stellen, und sie im Zweifel durch eine Interpretation ersetzen, die mir selbst Macht, Autorität oder Privileg verschafft.

Und da die Postmoderne bereits behauptet hat, dass alles, was existiert, Macht ist, warum sollten wir annehmen, dass es irgendetwas anderes gibt, das sie motiviert, etwas anderes als der Nackte Wille zur Macht? Dieses Denken beherrscht unsere Universitäten und dringt in den Rest unserer Gesellschaft ein, und die Idee, dass etwas Gutes dahinter steckt, ist eine gefährliche Idee. Ich denke, was dahinter steckt, ist genau das, was Nietzsche vor 150 Jahren notiert hat:

Es ist Missgunst, Bitterkeit und die Forderung nach Macht, die sich als Mitgefühl tarnt, und es ist an der Zeit, die Maske davon herunterzureißen und die Dinge in Ordnung zu bringen, bevor wir einen Weg weitergehen, der uns weiter in den Abgrund führt.