Temperatur-Manipulationen?

Eine aussagekräftige Datenanalyse hängt entscheidend von der Verfügbarkeit zuverlässiger Daten ab. Historisch gesehen ist es von größter Bedeutung, möglichst genaue Temperaturdaten zu haben, da diese einer der wesentlichen Prädiktoren für das zu erwartende Wetter sind. Auch die Langzeitbeobachtung von Klima und Klimatrends erfordert Temperaturdaten von höchster Qualität.

Was wäre, wenn Menschen und Institutionen anfangen würden, solche Daten zu verfälschen, weil die Daten, wie sie tatsächlich sind, nicht zu einer bestimmten politischen Agenda passen? Das würde – zumindest teilweise – die Schlussfolgerungen, die wir aus diesen Messungen ziehen, ungültig machen.

Leider sind genau solche vorsätzlichen Manipulationen von Temperaturdaten tatsächlich passiert. Einer der Meilensteine der Ereignisse ist eine Publikation von James Hansen „GISS analysis of surface temperature change“. In diesem Beitrag beschreibt Hansen eine Reihe von anscheinend notwendigen Anpassungen, die – in angeblich seltenen Fällen – an den Temperaturdaten vorgenommen werden müssen, um die Mittelung der Temperaturanomalien konsistent zu machen:

- Die häufigste Anpassung ist die Korrektur für den städtischen Wärmeinseleffekt. Dieser ist typischerweise eine Folge des städtischen Wachstums: Früher befand sich das Thermometer außerhalb einer Stadt in einer grünen Umgebung, mit dem Wachstum der Stadt ist es nun von Häusern umgeben und unterliegt dem städtischen Wärmeeffekt, der die Temperatur ansteigen lässt. Um dies mit der vorherigen Messung in Einklang zu bringen, werden entweder die vergangenen Temperaturen angehoben oder die zukünftigen Temperaturen abgesenkt. In der Regel ist es einfacher, die vergangene Temperatur anzupassen, indem man so tut, als wäre die Stadt immer so groß gewesen wie heute. Es ist fraglich, ob eine solche Anpassung gerechtfertigt ist, oder ob es nicht klüger wäre, den städtischen Wärmeeffekt stehen zu lassen und explizit zu verfolgen und dafür geschichtliche Tatsachen anzuerkennen, indem die tatsächlichen Messungen der Vergangenheit nicht verändert werden. Tatsache ist, dass eine Veränderung der vergangenen Temperaturen auch die damalige globale Mitteltemperatur verändert, was unter keinen Umständen gerechtfertigt ist.

- Eine zweite – eher verständliche – Situation zur Anpassung von Temperaturdaten tritt auf, wenn ein Thermometerstandort in eine größere oder geringere Höhe verlegt wird. Z.B. bei einer Höhenveränderung von 160m nach unten würde dies einer Temperaturerhöhung der bisherigen Daten um 1° C entsprechen, bei einem von Hansen angenommenen adiabatischen Temperaturgradienten von -6°/km . Physikalisch bedeutet dies die Invarianz der Potentialtemperatur, wenn der Energiegehalt des Gesamtsystems nicht verändert wird. Meinem Verständnis nach ist das die einzige legitime Anpassung nach Temperaturmessungen, weil sie den ursprünglichen wahren Messwert nicht verändert, sondern ihn lediglich auf einen anderen Ort abbildet, an dem vorher nicht gemessen wurde. Besser wäre allerdings eine zeitliche Abgrenzung der Thermometer-Gültigkeit ohne eine explizite Anpassung, wie es in anderen Gebieten der Datenverarbeitung selbstverständlich ist.

Die Transformation und Interpolation der Daten wäre dann ggf. bei der Auswertung durchzuführen. Dort findet ohnehin eine Interpretation der Daten statt, die bei seriösen Publikationen eine nachvollziehbare Rechtfertigung jedes Verarbeitungsschrittes beinhaltet.

Beide diese Anpassungen wurden in Hansens Arbeit erwähnt und begründet. Anzumerken ist, dass der dominante Fall der städtischen Wärmeinseln zu einem Anstieg der vergangenen Temperaturen oder zu einem Rückgang der aktuellen und zukünftigen Temperaturen führen muss (wenn man von dem in Zeiten starken Bevölkerungswachstums sehr seltenen Fall absieht, dass eine Stadt verlassen wird und vollständig verfällt).

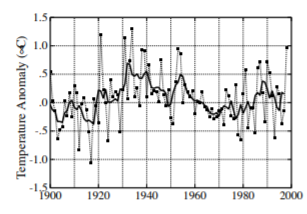

Die Zeitreihen der US-Mitteltemperaturen hat Hansen auf S. 47 seines Papiers veröffentlicht (unten links auf der Seite):

Es ist deutlich zu erkennen, dass die 3 höchsten Temperaturen im 20. Jahrhundert in den Jahren 1934, 1921 und 1931 lagen. Auch der gleitende Durchschnitt hat seinen Höhepunkt eindeutig in den frühen 1930er Jahren, und einen Abwärtstrend von den 30er Jahren bis zum Ende des Jahrhunderts.

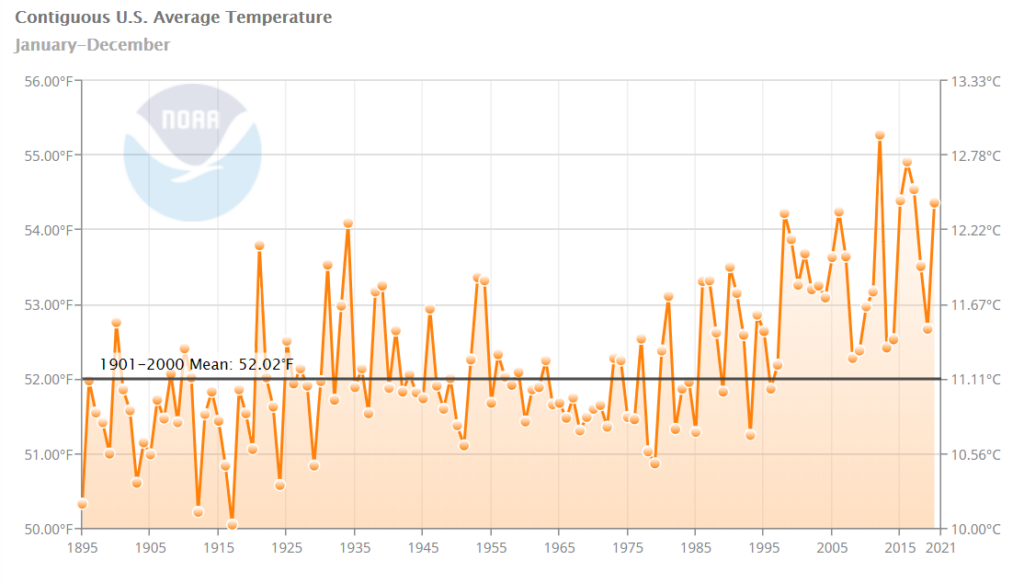

Wenn wir uns die heutigen Temperaturdaten ansehen, die online von NOAA verfügbar sind, sind wir überrascht, dies zu sehen:

Wenn man sich das Diagramm genau ansieht, kann man beobachten, dass die Temperatur von 1998 jetzt größer ist als die zuvor größte Temperatur von 1934, eine Erhöhung um fast ein halbes Grad Celsius! Eine Reihe der späteren Temperaturen des 20. Jahrhunderts wurden ebenfalls erhöht, während die früheren Daten des 20. Jahrhunderts reduziert wurden. Das ist genau das Gegenteil von dem, was man von einer Korrektur des städtischen Wärmeinsel-Effekts erwarten würde.

Durch ein Video von Tony Heller bin ich auf diese Problematik, die nach meinem Verständnis nur als vorsätzliche Manipulation gedeutet werden kann, aufmerksam geworden.

Detailierte Datenanalyse von Prof. Friedrich Ewert

Dass die Temperaturdaten der NASA/NOAA manipuliert wurden, hat Prof. Friedrich Ewert in einer langwierigen Analyse nachgewiesen. Demnach sind viele Temperaturdaten von vor 2010 nach dem Jahre 2012 verändert. Mit den heutigen Datensätzen sind die Originaldaten von vor 2010 nicht mehr zu finden. Prof. Ewert konnte die Vergleiche anstellen, weil er die früheren Datensätze rechtzeitig archiviert hatte.

Die Manipulationen beziehen sich nicht nur auf US-Temperaturdaten, sondern auch auf Daten anderer Länder. Für die 120 zufällig ausgewählten Stationen erfasste Ewert die zehntausenden von Einzeldaten, die die NASA für jedes Jahr vor und nach 2010 angibt. Würde man seine Daten ausdrucken, ergäbe sich eine 6 Meter lange Liste. Es ist zu erkennen, dass zehn verschiedene Methoden verwendet wurden, um einen Trend zur Klimaerwärmung zu erzeugen. Sie sind alle in der Studie mit Beispielen dokumentiert. 6 der 10 Beispiele wurden am häufigsten angewendet (Prof Ewert unterteilt den gesamten Zeitraum in aufeinanderfolgende Warm- und Abkühlungsphasen):

- Eine Absenkung der Jahresmittelwerte in der Anfangsphase.

- Eine Verringerung einzelner höherer Werte in der ersten Warmphase.

- Eine Erhöhung einzelner Werte in der zweiten Warmphase.

- Eine Unterdrückung der zweiten Abkühlungsphase ab etwa 1995.

- Eine Verkürzung der Datenreihen um die früheren Jahrzehnte.

- Bei Langzeitreihen wurden die Datenreihen sogar um die frühen Jahrhunderte verkürzt.

Die Climategate Emails

Die durchgesickerten „Climategate Emails“, die 2009 öffentlich wurden, liefern weitere Beweise dafür, dass die absichtliche Manipulation von Temperaturdaten keine Verschwörungstheorie, sondern eine echte Verschwörung zwischen mehreren Institutionen und Personen zumindest aus den USA und Großbritannien war, sorgfältig untersucht von Stephen McIntyre und Ross McKitrick, die bereits 2009 in ihrem Paper „Proxy inconsistency and other problems in millennial paleoclimate reconstructions“ die Täuschung des „Hockeysticks“ von Michael Mann entlarvten und aufdeckten.

Das berühmteste Beispiel für die absichtliche Temperaturmanipulation wurde von Phil Jones vom britischen Met Office in einer E-Mail an Michael Mann und Keith Briffa geäußert:

„Ich habe gerade Mikes Trick aus Nature angewandt, indem ich die realen Temperaturen zu jeder Reihe für die letzten 20 Jahre (d.h. ab 1981) und ab 1961 für die von Keith hinzugezählt habe, um den Rückgang zu verbergen.“

Hier das Diagramm aus dem zitierten Dossier von Stephen McIntyre und Ross McKitrick:

Absenkung der Temperatur von 2016

2016 war ein sehr heißes Jahr, und bislang das im globalen Durchschnitt das heißeste Jahr der jüngeren Vergangenheit. Die darauf folgenden Jahre waren deutlich kühler. Das Jahr 2020 war dann im globalen Durchschnitt fast so heiß wie das Jahr 2016. Um eines neuen Superlatives willen änderte die NASA im Nachhinein die Temperatur von 2016, damit der Trend zu immer neuen Hitzerekorden aufrecht erhalten werden konnte: